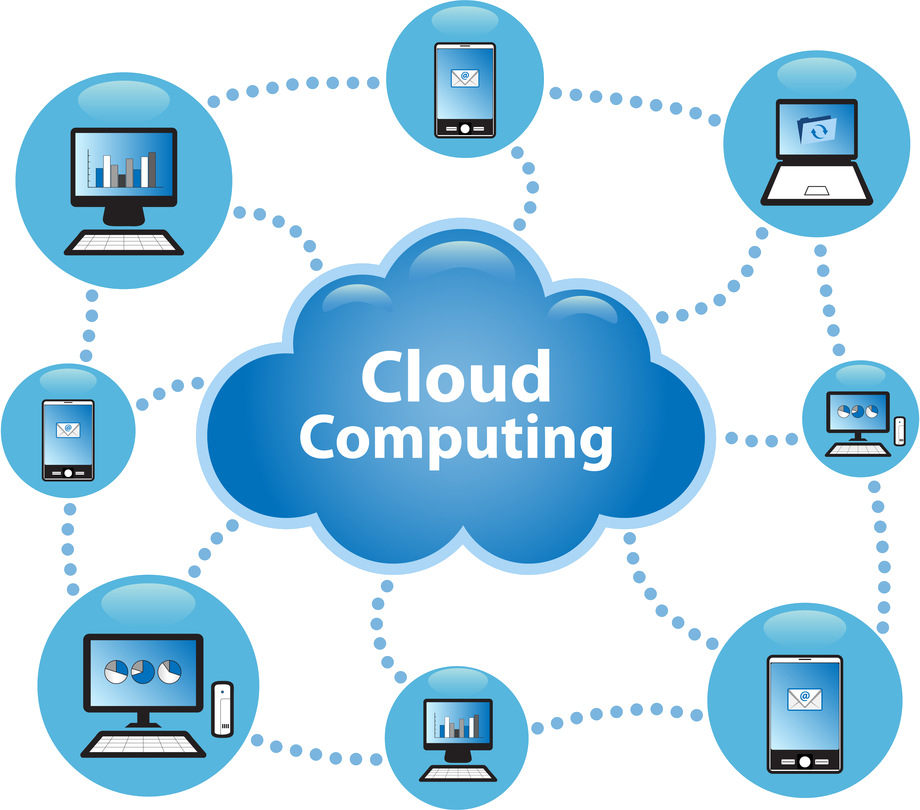

Le Cloud Computing souvent appelé Cloud (« le Nuage » en français) ou l’informatique en nuage désigne un accès aux ressources informatiques qui sont quelque part, à travers internet. Son accès est soit gratuit, comme c’est le cas avec le web mail soit sur abonnement, avec un niveau de service garanti.

Depuis longtemps, tout le monde utilise le Cloud computing sans même s’en rendre compte. Par exemple lorsque l’on utilise son webmail, Hotmail, Gmail ou autre, nous faisons du Cloud. Les entreprises achètent ainsi des capacités qui sont par la suite facturées un peu comme le sont l’eau, le gaz ou l’électricité. L’entreprise paye sa consommation. Cette consommation est illimitée, un peu comme le courant électrique.

Le Cloud computing représente la meilleure solution pour gérer une entreprise. Au lieu qu’une structure exécute des applications elle-même, c’est une plate-forme multi-tenant partagée qui s’en charge.

Le Cloud, il suffit simplement de s’y connecter, de le personnaliser et de l’utiliser. Son usage à l’air si simple… Cependant de nombreuses questions se posent.

A quoi sert le Cloud ?

Qui sont les acteurs du Cloud ?

Quelles sont ses plus-values ?

A t-il des limites ?

A quoi sert le Cloud ?

A l’ère du numérique, l’intégralité des applications d’entreprise migre sur internet. Le transfert des modèles logiciels traditionnels vers Internet ne cesse de croître. Le Cloud Computing, nous promet pour ces années à venir, de nouveaux modes de collaboration omniprésents, par l’intermédiaire de nos périphériques mobiles.

Les entreprises utilisent toutes sortes d’applications dans le Cloud, telles que des applications de CRM / GRC, de RH, de comptabilité et même des applications métiers. Ces applications présentes dans le Cloud peuvent être opérationnelles en quelques jours seulement. Contrairement avec les logiciels d’entreprise traditionnels. Elles sont peu onéreuses, car il n’est pas nécessaire d’investir dans du matériel et des logiciels, ni à dépenser de l’argent pour la configuration et la maintenance de couches technologiques complexes, ni à financer les installations permettant de les exécuter. Ces applications se voient être plus évolutives, plus sûres et plus fiables que la plupart des applications.

En règle générale, les applications bénéficient automatiquement de toutes les améliorations de sécurité et de performances disponibles, ainsi que des nouvelles fonctionnalités. Or, ici les mises à jour sont intégralement prises en charge.

Le mode de paiement diffère complètement. Inutile d’acheter des serveurs et des logiciels car les applications sont basés dans le Cloud. Tout est compris dans un abonnement mensuel fixe et l’on ne paye qu’à l’utilisation.

Le Cloud computing permet d’éliminer tout type de difficultés notamment lorsqu’une entité ne gére aucun matériel ni logiciel. Tout cela est du ressort d’un fournisseur expérimenté.

Les principaux acteurs du cloud computing et ses services

Les principales entreprises du secteur sont Amazon, Citrix, Google, HP, IBM, Intel, Microsoft ou SalesForces.

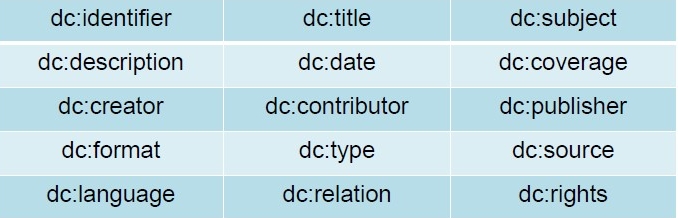

Le cloud computing est essentiellement une offre commerciale d’abonnement économique à des services externes. Selon le National Institute of Standards and Technology, il existe trois catégories de services qui peuvent être offerts en cloud computing : IaaS, PaaS et SaaS.

- Infrastructure en tant que service (IaaS) :

Dans ce service, les sociétés accèdent à des serveurs physiques ou virtuels selon un modèle de paiement à l’utilisation. Cela leur permet de payer uniquement l’espace qu’elles utilisent. Cette catégorie recoupe fréquemment celle du PaaS et la distinction entre les deux est souvent difficile à faire.

Il y a les fournisseurs, tels que Amazons Elastic Compute Cloud (EC2).

Il y a aussi les consommateurs qui sont ici fournisseurs de développement et fournisseurs informatiques.

- Logiciel en tant que service (SaaS) :

Ce service représente la quasi-totalité des programmes que l’on utilise sur Internet.

Il y a les fournisseurs. Ces derniers désignent tous les fournisseurs en ligne, salesforce.com, Google Docs, Facebook.

Il y a les consommateurs qui représentent la quasi-totalité des internautes.

- Plate-forme en tant que service (PaaS) :

Ce service représente les services que les développeurs utilisent pour créer des applications cloud métiers.

Il y a les fournisseurs, tels que Force.com, Google App Engine.

Il y a également les consommateurs qui sont développeurs Web et développeurs d’applications.

Quels sont ses avantages ?

Le cloud computing dispose de nombreux avantages, tels que :

- Des mises à jour logicielles automatiques :

Avec le cloud computing, la maintenance du serveur est réalisée par des professionnels dont c’est le métier. Leur réputation repose sur les meilleures pratiques de maintenance.

Exemple : Bien que la perte de contrôle soit le problème majeur évoqué par les sociétés (une enquête menée par InformationWeek montre que le « contrôle » constitue l’une des trois préoccupations essentielles des participants à l’étude en matière de cloud), la plupart des entreprises reconnaissent les avantages d’un système flexible (65 % des personnes interrogées ont déclaré que « la capacité à répondre rapidement aux besoins de l’entreprise » constituait la raison principale de leur migration vers le cloud computing).

- Un coût inférieur :

Les fournisseurs de services de cloud computing partagent leurs serveurs et leurs infrastructures complexes, tandis que les clients paient uniquement l’espace de stockage qu’ils utilisent, ce qui leur permet d’économiser de l’argent.

Exemple : Une étude menée par Osterman Research a démontré qu’en 2010 les entreprises ont dépensé 6 335 dollars en moyenne pour les services de cloud computing, soit 23,31 dollars par employé. Selon les prévisions, ce chiffre devrait atteindre 26,63 dollars, soit un total de 6 920 dollars.

- Une solution flexible :

Les systèmes cloud sont évolutifs : les services et l’utilisation peuvent ainsi être augmentés ou diminués à la demande, en fonction de l’activité.

Exemple : Amazon.com a d’abord commencé à proposer et à vendre des prestations de cloud computing car, au cours d’une journée ordinaire, le site n’utilisait que 10 % des ressources de ses serveurs. Les 90 % restants n’étaient utilisés qu’en cas de forte demande de service.

- Une solution mobile :

Les utilisateurs peuvent accéder à leur contenu où qu’ils se trouvent, grâce à une simple connexion Internet.

Exemple 1 : vers la fin de l’anné 2010, environ 940 millions d’abonnements 3G étaient recensés à travers le monde. Ainsi, près d’un milliard d’utilisateurs avaient la possibilité de travailler sur leurs téléphones portables aux quatre coins du globe.

Exemple 2 : Gartner prévoit que d’ici 2013, 1,6 milliard de terminaux mobiles seront utilisés dans le monde, les smartphones, tablettes et ordinateurs portables représentant le segment à la croissance la plus rapide.

(Source : Gartner Research, Smartphone, Tablet, and PC Forecast, décembre 2010.)

Quels sont ses limites ?

Le cloud computing a ses inconvénents.

- Sécurité du cloud :

L’utilisation des réseaux publics entraîne des risques liés à la sécurité du cloud. La connexion entre les postes et les serveurs applicatifs passe par le réseau internet, et expose à des risques supplémentaires de cyberattaques, et de violation de confidentialité.

- Dépendance du client à la qualité du réseau des services du cloud :

Le client d’un service de cloud computing devient très dépendant de la qualité du réseau pour accéder à ce service. Aucun fournisseur de service cloud ne peut garantir une disponibilité de 100 %.

- Perte de la main mise sur les données :

Les entreprises perdent la maîtrise de l’implantation de leurs données. De ce fait, les interfaces inter-applicatives (qui peuvent être volumineuses) deviennent beaucoup plus complexes à mettre en œuvre que sur une architecture hébergée en interne.

- Plus de garantie :

Les entreprises n’ont plus de garanties (autres que contractuelles) de l’utilisation qui est faite de leurs données, puisqu’elles les confient à des tiers.

- Questionnements juridiques :

Les questions juridiques posées notamment par l’absence de localisation précise des données du cloud computing. Les lois en vigueur s’appliquent, mais pour quel serveur, quel data center, et surtout quel pays ?

- Attaque des services cloud :

Tout comme les logiciels installés localement, les services de cloud computing sont utilisables pour lancer des attaques (craquage de mots de passe, déni de service…).

Exemple : En 2009, un cheval de Troie a utilisé illégalement un service du cloud public d’Amazon pour infecter des ordinateurs.

- Exportation des données impossible :

Il n’est pas toujours possible d’exporter les données d’un service cloud. De ce fait la réversibilité (ou les coûts de sortie associés) n’est pas toujours prise en compte dans le cadre du projet. Le client se trouve souvent « piégé » par son prestataire et c’est seulement lorsqu’il y a des problèmes qu’il se rend compte de l’enfermement propriétaire (vendor lock-in) dans lequel il se trouve.

En conclusion…

Le cloud computing est une récente innovation. Il accroît l’efficacité et la souplesse des sociétés dans la mesure où il permet de travailler à plusieurs sans contrainte (technique, horaire, géographique…), de gérer à la carte les logiciels et donc les fonctionnalités utilisées, de ne plus s’occuper de tâches longues, compliquées et contraignantes liées à la technique, de gagner du temps en limitant les ressaisies et surtout de faire des économies.

Le cloud a pour objectif de décharger l’utilisateur des problématiques serveur et lui permettre de disposer de ses données et de ses outils où qu’il soit, dès qu’il a une connexion Internet.

Cependant celui-ci ne reste pas sans faille.

L’ONG Greenpeace dénonce, dans son rapport 2010 sur l’impact écologique du secteur informatique, les impacts négatifs de l’informatique en nuage. Selon, Richard Stallman, qui est à l’origine du projet GNU, l’informatique dans le nuage « est un piège ». Les utilisateurs perdent le contrôle de leurs applications. Il le considère comme un concept publicitaire sans intérêt. Selon Larry Ellison, fondateur d’Oracle, le cloud est un phénomène de mode.

Récemment, Steve Wozniak, cofondateur d’Apple avec Steve Jobs, prévoit également des problèmes avec le développement croissant du cloud computing et l’externalisation des données.

Le cloud computing est un phénomène qui fait beaucoup parler de lui de par sa facilité d’exploitation des données.

Quelques vidéos…

- Cloud Computing Explained :

- Presentation: Bridgeworks at Enterprise Cloud Computing & Virtualization March 2014 :

- IBM Cloud and SoftLayer: Flexible, private cloud infrastructure :

Sources

- http://www.bloomberg.com/news/2014-10-13/emc-acquiring-cloud-computing-startup-cloudscaling.html

- http://www.lesechos.fr/tech-medias/hightech/0203899205495-lindien-tata-accelere-dans-le-cloud-computing-1058917.php

- http://www.ecommercemag.fr/Thematique/solutions-1011/Tribunes/le-cloud-computing-a-lassaut-des-entreprises-246807.htm

- http://www.challenges.fr/publi-communique/20141002.CHA8505/marche-du-cloud-computing-en-france-les-chiffres-cles-2014.html

- http://www.lesechos.fr/enjeux/business-stories/management/0203815572437-cloud-computing-quand-les-entreprises-se-branchent-au-nuage-1049794.php