Cet article est un résumé analytique du chapitre intitulé « Le papier contre l’électronique » de Hubert GUILLAUD, issu du livre READ / WRITE BOOK.

Ce compte rendu met en avant les idées principales de la thématique du chapitre.

Un support, une nouvelle culture…

Lit-on de la même manière sur le support papier que sur le support électronique ?

A l’époque, Socrate relatait que la transmission du savoir se faisait de « manière orale ».

Ce rapport de transmission de savoir a évolué depuis la naissance de l’hypertexte (Papyrus à hypertexte).

Ce paradoxe confronte deux mondes : les anciens aux modernes.

Les anciens sont déterminés à penser que le papier est indépassable. Contrairement aux modernes, pensant que le changement des connaissances vers l’électronique est inévitable.

Une idée est mis en avant : l’attention, la concentration et la mémorisation seraient transformées par le support. Cette idée est-elle démontrée ?

De ce fait, il est fondamental de choisir le support adéquat, écran ou papier, pour une meilleure lecture.

- « Google nous rend-il stupide ? »

Selon Nicholas Carr, Internet dénature notre capacité de concentration.

Il explique, d’après sa propre expérience professionnelle, qu’aujourd’hui il est difficile de lire un livre dans son intégralité avec attention et concentration. D’après lui, l’esprit change. Le commun des mortels ne pense plus de la même façon qu’avant. Il en va de même pour la lecture. Auparavant celle-ci était profonde et naturelle. Aujourd’hui la lecture est devenu une épreuve.

Le théoricien des médias Marshall McLuhan faisait remarquer dans les années 60, que les médias ne sont pas uniquement un canal passif d’informations. Au contraire, ces derniers fournissent les bases de réflexion et modèlent le processus de pensée. Selon lui, l’Internet érode la capacité de concentration et de réflexion. Aujourd’hui l’esprit attends l’informations de la façon dont le Net les distribuent. Les informations de masse sont définies comme un flux d’informations. Ce trop pleins d’informations n’est qu’en réalité un flux de particule s’écoulant rapidement.

Ces théories peu développées nous rapportent toujours vers la problématique qui est : quel support exploiter ? Le papier ou l’écran ?

L’électronique transforme probablement la manière dont on lit. Or, cette transformation est-elle réalisée dans la mauvaise direction ?

- Nos références culturelles changent

Le flux d’informations est un « flot qui nous noie » de par sa quantité de données.

Selon Daniel Hillis : « Google ne rend pas stupide ».

A l’ère de la technologie, l’individu a besoin de plus d’information. Pourquoi ?

Cette réalité se traduit par le fait que la technologie a détruit l’isolement dans lequel les communautés affrontent le monde d’aujourd’hui. Mais également parce que le monde a changé et il est devenu compliqué. Un besoin fort d’en savoir toujours davantage apparaît pour diverses raisons :

– Besoin de prendre plus de décision, telles que choisir sa religion, choisir son propre service de communication, son propre service de santé…;

– Besoin d’être mieux connecté à notre service environnement et mieux le comprendre ;

– Besoin d’être plus intelligent.

L’historien George Dyson énonce que « nous sommes face à un risque ». Selon lui, nous perdons les moyens de penser mais nous les remplaçons par autre chose de neuf. Les choses élémentaires telles qu’aiguiser un couteau de chasse ou construire un carburateur est plus important qu’avoir moins de gens qui lisent un livre. La technologie a entériné le déclin des albums par le biais des IPod, MP3, l’apogée des Play List etc. L’avantage c’est que beaucoup plus de monde écoute de la musique.

Si la culture livresque tend à disparaître, il y a une forte capacité de lecture et d’écriture par l’utilisation dense des outils informatiques. L’univers quotidien se peuple davantage de lecture. Celle-ci devient multiple et variées : mails, blogs, twitts, journaux et jeux qui s’ajoutent aux livres.

- Le web : un nouveau rapport à la culture

Clay Shirky, auteur d’un livre sur « la puissance de l’auto-organisation relate que l’anxiété de Nicholas Carr ne traduit pas l’évolution de la pensée ou de la lecture mais plutôt l’horizon d’un changement de culture. Selon lui, nous lisons fortement plus qu’avant mais plus de la même manière. Le monde de la littérature a perdu sa centralité et perd maintenant sa main mise sur la culture.

Daniel Hills énonce qu’il aime les livres plus pour les idées que pour le format.

Depuis longtemps, les livres sont les premiers vecteurs des idées. Les gens pensent que les livrent sont le meilleure véhicule de la pensée et des histoires. Est-ce exact ? Aujourd’hui les films bouleversent plus que les livres. Il en a de soit pour les documentaires. Ces derniers apprennent plus et font plus réfléchir. La lecture est un acte non naturel, quelque chose que nous avons appris pour faire passer nos idées dans le temps et l’espace.

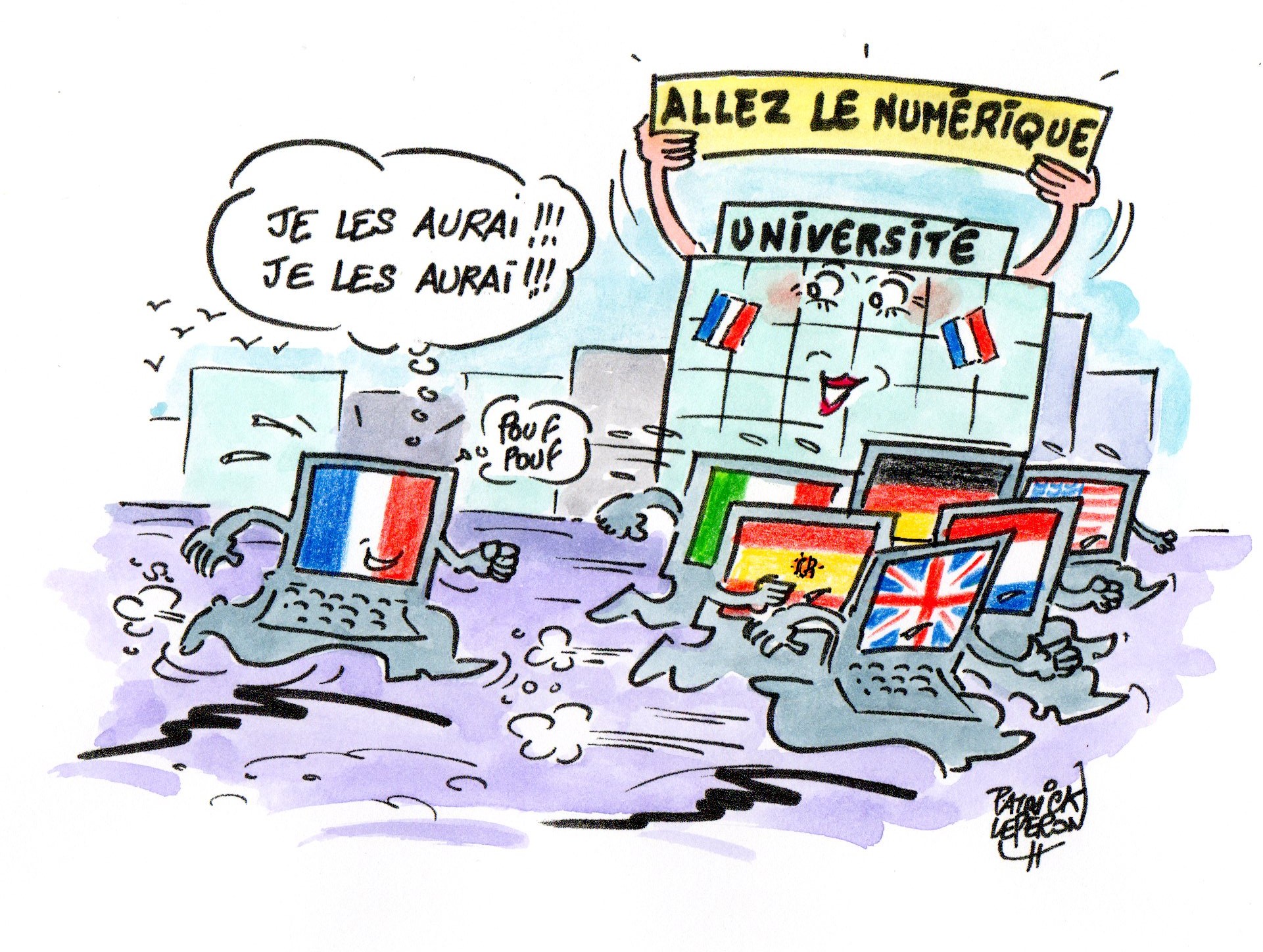

Le passage du papier à l’électronique est plus qu’un changement de support. C’est en réalité un changement de culture. C’est le passage de la culture de l’imprimé à la culture du web et de l’hypertexte.

Selon Franck Beau, Internet modifie no références culturelles. Internet modifie également les racines où l’on puise notre culture. Ce glissement culturel se fait dans la douleur. Partout le numérique remplace le matériel.

Ces deux cultures tendent à s’opposer :

La culture numérique : déplore « vicariance » des écrans, l’état quasi hypnotique dans lequel l’écran nous absorbe, court-circuite en partie notre raison.

La culture de l’écrit papier : est déprécié car il reflète le symbole de a culture des générations finissante.

« Nous sommes ce que nous lisons », Alberton Manguel.

Aujourd’hui nous ne lisons plus les mêmes textes ni avec les mêmes outils et plus dans les mêmes conditions donc nous ne serons peut-être plus les mêmes hommes.

Lequel nous rend intelligent ?

Pour répondre à cette question, il est indispensable de mesurer l’impact des différents supports.

- Le calme est bon pour l’esprit.

Psychologue, neurologue Maryanne Wolf dirige un centre de recherche pour la lecture et le langage de la Tufts University.

Elle explique comment l’espèce humaine a appris à ire et comment la lecture transforme nos fonctions cérébrales de l’enfant.

« L’acte de lecture n’est pas naturelle ».

La lecture est une invention culturelle récemment acquise. L’efficacité que nous avons développée grâce à la lecture nous a permis d’avoir plus de temps pour réfléchir.

La lecture nous rend plus intelligents car elle laisse notre cerveau seul avec lui-même. Elle le laisse penser sans être déranger contrairement à ce qui arrive lors d’une conversation par exemple.

Plusieurs études pour mesurer la différence entre la lecture attentive et silencieuse et une lecture troublée par un commentaire audio :

– Ceux qui lisent silencieusement une présentation ppt la trouvent plus intéressante que ceux qui a lise avec une présentation active ;

– Ceux qui lisent en silence se souviennent plus que ce qui regardent un écran ;

– Les cobayes qui lisent les transcrits d’infos, de pubs, programme politique… ont une mémoire meilleure que ceux qui n’ont fait que les regarder à la TV.

Il faut se donner quelques règles pour lire ou écrire à l’ère de la distraction permanente comme le dis Cory Doctorow.

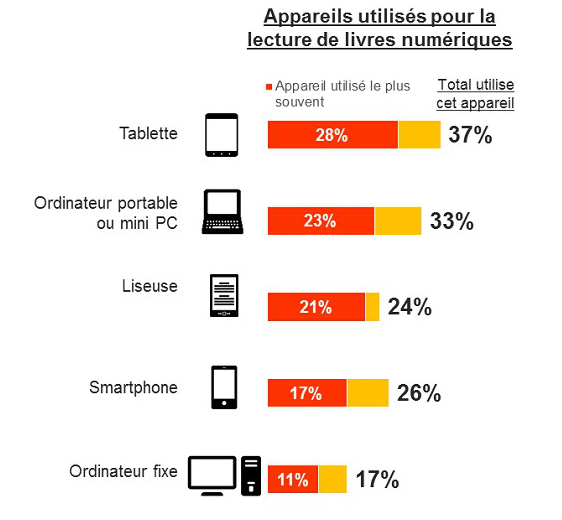

Notre façon de lire profondément sur le web. A l’écran nous lisons as, nous écrémons. Les lecteurs de livres électronique tendent à y piocher des passages plutôt que d’en lire l’intégralité, selon l’étude Superbook, qui a donné naissance à un Observatoire national des usages des livres électroniques en milieu académique.

La lecture ne consiste pas seulement à absorber l’information et trouver des réponses toutes prêtes : elle est « pensée en action ».

Le web risque de nous faire perdre la « dimension associative » de la lecture qui nous permet d’entrevoir de nouveaux horizons intellectuels.

- La technologie n’est pas responsable de l’idiotie commune

Si le web ne nous rend pas plus intelligent que le papier peut-être peut-il nous rendre bête ?

Selon David Wolman, l’internet ne nous a pas conduit dans un nouvel âge noir, bien au contraire ! Le web nous donne un remarquable accès à toutes les idées les plus stupides en les amplifiant bien souvent. L’irrationalisme de nos sociétés n’est pas la faute de la technologie. Au contraire « l’exposition de la connaissance représentée par l’internet et encouragée par toutes sortes de technologies numériques nous a rendu plus productifs et nous a offert l’opportunité de devenir plus intelligents, et non plus bêtes ».

- Le web : plus stimulant que le papier !

La réalité virtuelle, selon Jaron Lanier, est plus critique encore.

Certaines technologies peuvent effectivement nous rendre stupides (casinos, tabloïds, cocaïne) et il y a des technologies numériques qui renforcent les aspect les moins brillants de la nature humaine.

Kevin Kelly, ancien rédacteur en chef de Wired : le web nous rend plus intelligents. « Laissons Google nous rendre plus intelligent ».

Selon des neuroscientifiques de l’université de Californie, la stimulation cérébrale générée par la consultation de l’internet est plus forte que celle générée par la lecture traditionnelle.

Internet nécessite de prendre sans arrêt des décisions, ce qui n’est pas le cas d’une lecture classique, qui ne nécessite pas de choix constants ou complexe. Internet favorise aussi peut-être la mémorisation, puisque celle-ci réussit mieux quand le récepteur est actif plutôt que passif.

Selon thomas Clabun, il est difficile de savoir qui du papier ou de l’électronique rend plus intelligent.

Les deux supports stimulent différemment notre intelligence certainement aussi parce que nos chercheurs ont encore bien du mal à définir ce qu’est intelligences ou plutôt que sont les différentes formes d’intelligences.

Vers de nouvelles manières de lire…

Philosophe Larry Sanger, répond à l’inquiétude de Nicholas Carr (devenu incapable de lire des documents long à force de parcourir des formes courtes sur le web).

Si aujourd’hui l’on est plus capable de lire des livres c’est à cause d’un manque de volonté personnelle.

La problématique : Le média a-t-il un impact sur notre capacité de concentration ?

Jeremy Hatch, notre capacité à nous concentrer sur un long texte ne dépend pas du média qui le délivre mais de notre discipline personnelle et l’objectif que nous avons quand nous lisons.

Kelly Kevin, l’espace de littérature est orthogonal au cyberespace et à l’espace de lecture. Selon le professeur Laurent Cohen, « le support ne crée pas beaucoup de différence au niveau visuel ». c’est à dire du point de vue des capacités de lectures, l’écran ou le papier ne changent rien au processus de la lecture, si l’on prend le même texte proposé d’une manière brute sur l’un ou l’autre support. Ce n’est pas lire sur un écran qui nous perturbe mais c’est lire connecté, lire en réseau.

- C’est le réseau qui nous distrait

Selon Cory Doctorow, les distractions que le réseau et les outils numériques facilitent nous distrait. Parce que micro-interaction ; mises à jour continues. L’ordinateur nous conduit à être « multitâches ». c’est à dire accomplir plusieurs tâches qui demandent cognitivement peu d’attention ;

Faut-il imaginer des outils qui nous déconnecte selon ce qu’on lit pour favoriser notre concentration ? Mais il est probable que l’on puisse de moins en moins lire en n’étant pas connecté.

Pourrons-nous demain lire des livres sans accéder à leurs commentaires, au système documentaires qui va naître de cette mise en réseau des contenus. Google Books préfigure peut-être ces nouvelles formes de lectures avec par exemple, la page de références, citation, meilleures passages et des recommandations d’un livre de référencer dans Google Books.

La lecture ne sera plus une expérience solitaire car en accédant au livre, à un article, on accèdera aussi aux lectures d’autres lecteurs, à son importance culturelle et au système qui le référence.

- Notre mode de lecture change parce que le numérique favorise de « nouvelle manières » de lire

Première étude sur les usages des livres électroniques montre qu’on ne les utilise pas de la même façon que les livres papiers. Plutôt que d’en faire une lecture linéaire on y pioche des passages et des chapitres.

Le changement du paradigme que suppose le livre électronique ne signifie peut-être pas un accès en tout lieux, tout moment, mode plutôt linéaire comme un livre papier.

Ce que nous lisons est différents car la posture de lecture est différent. Avec un livre (je lis, moment à part, j’absorbe l’infos). Sur un écran , un livre électronique (je lis et écris, lis et communique bien souvent).

Ces nouvelles manières de lire brouillent les questions de lecture, nos façons de les mesurer et de les comptabiliser.

Qu’est-ce que lire ?

Motoko Rich, relate que tout l’enjeu consiste à redéfinir ce que signifie lire à l’ère numérique.

- Quels sont les effets de la lecture en ligne sur nos capacités de lecture ?

Les tests de lectures des plus jeunes se dégradent. Beaucoup d’enfants lisent en ligne que sur papier. Les jeunes qui lisent pour s’amuser ou dans leur temps libre obtient de meilleures scores que ceux qui lisent dans le cadre scolaire.

Différentes études ont été faites :

– Des spécialistes de l’alphabétisation font une étude sur 700 personnes pauvres hispanique et noire de Detroit. Les jeunes lisent plus sur le web que sur n’importe quel autre média. Seul le seul type de lecture améliorant leur résultat scolaire est la lecture de romans.

– Chercheurs de Michigan : l’usage d’internet chez les enfants et adolescents ont montré que la qualité et l’aptitude à lire s’améliorent à mesure qu’ils passent du temps en ligne.

Les rapports insistent sur la réduction en fréquence et en quantité de lecture chez les plus jeunes alors que progresse leur temps passé sur le web. Baisse plus forte chez les garçons que chez les filles. Internet n’est pas le seul responsable. Il y aussi les jeux vidéo et les mobiles.

Olivier Donnat, relate que la modification pratique de lecture est antérieure à l’arrivée du Net. Depuis 1980 il y a une transformation du format de lecture.

On ne sait pas grand chose des passerelles entre la lecture papier et écran. On ne les mesures pas, on ne les voit pas, on ne les identifie pas. La lecture n’est plus une activité isolée. Elle s’inscrit dans un ensemble d’activités dont elle est l’une des articulations. On joue, lit, écoute, écrit, consulte… surfer sur le net, consulter ses mails ou Wikipédia, est-ce encore lire ? oui !

Certains experts relatent que c’est la lecture elle-même qu’il faudrait redéfinir.

- Vers de nouvelles sociologies de la lecture

Difficile d’évaluer les différentes façons de lire car on lit de différentes façons pour différentes raisons. Il y a autant de lectures que de lectures.

La sociologue Chantal Horellou-Lafarge et Monique Segré soulignent la grande diversité des pratiques de lectures. Variation selon les sexes, le milieu social et niveau d’instruction.

La lecture électronique se vit dans des « contextes » sociaux et historique personnelle.

La concurrence entre les nouvelles technologies et les anciennes pratique culturelle se fait en terme de d’occupation du temps au détriment des formes traditionnelles, mais pas aux détriments des contenus.

L’accès à la culture sur le web ne transforme pas les valeurs culturelles des internautes.

Chacun demeure avant tout le reflet du groupe social auquel il appartient. Pour tirer bénéfice de la culture, il faut le vouloir.

En conclusion…

Lecture sur papier, lecture sur écran, quelles différences ?

Quel impact sur l’intelligence et la culture d’autrui ?

Cette analyse ci-dessus a exploré le sujet sous plusieurs angles et a confronté divers points de vues.

De nombreuses recherches ont été réalisé en France et à l’étranger afin d’apporter un maximum de réponses concernant ces questionnements.

Ces recherches ont été menées par l’inspection générale, enseignants, ergonomes, historiens, neuroscientifiques, philosophes, sociologues…

Une étude a été menée par Ricoh Americas Corporation, en collaboration avec l’Université du Colorado afin de montrer qu’en dépit des avantages du livre numérique, le format imprimé reste plus efficient au coeur des lecteurs.

Les deux cultures, papier et numérique ont eu un réel impact sur l’esprit et les pratiques quotidiennes des individus.

Les modes de lecture, les processus cognitifs, les aspects pédagogiques, les aspects socio-culturels, les critiques d’Internet et des nouveaux médias ont évolué.

Pour en savoir davantage sur ce sujet, cliquez ICI.

http://credit-n.ru/zaymyi-next.html