Quelle source d’énergie pour alimenter le monde ?

Du point de vue de la physique, toute action se décrit en terme de transfert d’énergie. Pour rouler, une voiture brule de l’essence : il s’agit d’une réaction chimique qui convertit de l’énergie potentielle chimique en énergie cinétique. De la même façon, une centrale électrique convertit de l’énergie primaire (hydraulique pour un barrage, chimique pour du charbon, nucléaire pour une centrale nucléaire) en énergie électrique.

L’activité du monde économique est basée sur cette conversion d’énergie primaire en une autre forme d’énergie. Une énergie primaire est une énergie naturellement accessible. Il n’y en a pas tant que ça :

- Energie hydraulique : l’énergie des cours d’eau, des marées

- Energie éolienne : l’énergie cinétique du vent

- Energie chimique : l’énergie potentiellement libérable du charbon, du pétrole

- Energie solaire : l’énergie lumineuse reçue du soleil

- Energie nucléaire : l’énergie de cohésion des noyaux nucléaires

Les 3 premières sont en fait des « filles » de l’énergie solaire. Récupérer les énergies hydrauliques et éoliennes revient à prélever une infime partie des énergies mise en oeuvre dans la machinerie climatique de la terre. L’énergie chimique fossilisée est issue d’organismes vivants, or tous les organismes vivants puisent leur énergie du soleil : les plantes transforment l’énergie solaire en énergie chimique, les animaux mangent les plantes et profitent de cette énergie chimique.

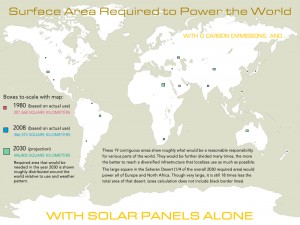

L’économie actuelle est essentiellement basée sur l’énergie chimique, une source d’énergie épuisable qui en plus modifie l’équilibre physico-chimique du climat. La question des énergies renouvelables est celle de la recherche d’une source d’énergie primaire économiquement rentable et écologiquement acceptable. Le solaire est certainement le meilleur candidat. En témoigne la carte présentée qui montre une estimation de la surface de panneaux solaires nécessaire pour alimenter le monde.

Actuellement, nos voitures fonctionnent en effectuant une réaction d’oxydation des hydrocarbures présents dans l’essence :

Actuellement, nos voitures fonctionnent en effectuant une réaction d’oxydation des hydrocarbures présents dans l’essence : La première idée qui vient à l’esprit c’est de remplacer l’essence par un carburant tout aussi énergétique mais renouvelable. Ainsi, certains constructeurs ont mis au point des voitures qui roulent au bioéthanol. Ce carburant est d’origine agricole. C’est à dire qu’on le produit à partir de colza ou d’autres huiles végétales.

La première idée qui vient à l’esprit c’est de remplacer l’essence par un carburant tout aussi énergétique mais renouvelable. Ainsi, certains constructeurs ont mis au point des voitures qui roulent au bioéthanol. Ce carburant est d’origine agricole. C’est à dire qu’on le produit à partir de colza ou d’autres huiles végétales. L’idée qui vient immédiatement à l’esprit est l’utilisation de panneaux solaires. En effet, l’énergie solaire est gratuite, directement accessible et éternellement renouvelable (tout du moins pour les 4 milliards d’années à venir). Encore une fois, il y a un hic : la terre reçoit du soleil environ 1000 Watt par m2 (1 kW/m2). Ainsi, il faut présenter une grande surface de panneau solaire pour faire avancer une voiture (voir l’image ci-contre). Une petite voiture développe environ 100 chevaux ce qui correspond à 100 kW. Il faudrait donc 100 m2 de panneaux solaires pour avoir la même puissance : il va falloir revoir la taille de nos routes !

L’idée qui vient immédiatement à l’esprit est l’utilisation de panneaux solaires. En effet, l’énergie solaire est gratuite, directement accessible et éternellement renouvelable (tout du moins pour les 4 milliards d’années à venir). Encore une fois, il y a un hic : la terre reçoit du soleil environ 1000 Watt par m2 (1 kW/m2). Ainsi, il faut présenter une grande surface de panneau solaire pour faire avancer une voiture (voir l’image ci-contre). Une petite voiture développe environ 100 chevaux ce qui correspond à 100 kW. Il faudrait donc 100 m2 de panneaux solaires pour avoir la même puissance : il va falloir revoir la taille de nos routes ! Le dihydrogène (H2) réagit très violemment avec le dioxygène de l’air pour former de l’eau :

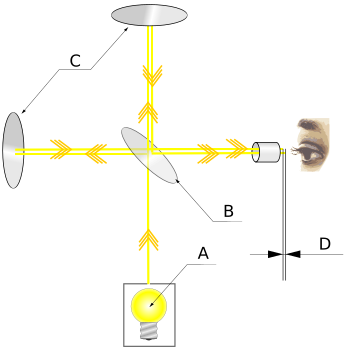

Le dihydrogène (H2) réagit très violemment avec le dioxygène de l’air pour former de l’eau : Cette question est cruciale dans tous les systèmes de pensées scientifique puisqu’elle permet de comprendre la façon dont on appréhende le monde. Ainsi, pour les atomistes grecs les objets émettaient des particules reproduisant la forme des objets de manière réduite dans notre oeil. Pour Euclide et les pythagoriciens, c’est notre oeil qui émet un « quid » et permet la vision. Cette description sera réfutée par Aristote car alors nous pourrions voir les objets la nuit, même en l’absence de lumière. Cependant, c’est du côté de l’Egypte que l’optique géométrique a été minutieusement étudiée avec les travaux d’Alhazen (Ibn Al-Haytham). Dans son livre « Les trésors de l’optique » (écrit entre 1015 et 1021, traduit en latin en 1572), il décrit la lumière de manière mécaniste, comme un flux de sphères pesantes, émis de sources ponctuelles en des rayons rectilignes, susceptibles d’être réfléchies, réfractées et perçues par l’oeil. Son livre traite également des lentilles (incluant l’oeil), des miroirs plans et curviligne, des couleurs et de la camera obscura (Une boîte noire percée d’un trou : le principe de la chambre noire). Son approche expérimentale et mathématique restera inégalé pendant 500 ans.

Cette question est cruciale dans tous les systèmes de pensées scientifique puisqu’elle permet de comprendre la façon dont on appréhende le monde. Ainsi, pour les atomistes grecs les objets émettaient des particules reproduisant la forme des objets de manière réduite dans notre oeil. Pour Euclide et les pythagoriciens, c’est notre oeil qui émet un « quid » et permet la vision. Cette description sera réfutée par Aristote car alors nous pourrions voir les objets la nuit, même en l’absence de lumière. Cependant, c’est du côté de l’Egypte que l’optique géométrique a été minutieusement étudiée avec les travaux d’Alhazen (Ibn Al-Haytham). Dans son livre « Les trésors de l’optique » (écrit entre 1015 et 1021, traduit en latin en 1572), il décrit la lumière de manière mécaniste, comme un flux de sphères pesantes, émis de sources ponctuelles en des rayons rectilignes, susceptibles d’être réfléchies, réfractées et perçues par l’oeil. Son livre traite également des lentilles (incluant l’oeil), des miroirs plans et curviligne, des couleurs et de la camera obscura (Une boîte noire percée d’un trou : le principe de la chambre noire). Son approche expérimentale et mathématique restera inégalé pendant 500 ans. Selon Newton, la lumière est constituée de corpuscules soumis à l’action des forces. Cela permet d’expliquer le comportement de la lumière comme on l’observe en optique géométrique : réfraction (changement de direction de la lumière lors de la traversée des milieux transparents), réflexion (comme pour un miroir) et modification du trajet de la lumière par les lentilles. En observant le phénomène de dispersion par un prisme (tel qu’il est étudié en classe de 2de), il en déduit que ces corpuscules sont de différents types, correspondant aux différentes couleurs perçues par l’oeil.

Selon Newton, la lumière est constituée de corpuscules soumis à l’action des forces. Cela permet d’expliquer le comportement de la lumière comme on l’observe en optique géométrique : réfraction (changement de direction de la lumière lors de la traversée des milieux transparents), réflexion (comme pour un miroir) et modification du trajet de la lumière par les lentilles. En observant le phénomène de dispersion par un prisme (tel qu’il est étudié en classe de 2de), il en déduit que ces corpuscules sont de différents types, correspondant aux différentes couleurs perçues par l’oeil. Ainsi, à partir du milieu du XIXème siècle, les scientifiques furent convaincus que la lumière était une onde. Il restait à déterminer dans les propriétés du milieu dans lequel se propageait cette onde (voir l’

Ainsi, à partir du milieu du XIXème siècle, les scientifiques furent convaincus que la lumière était une onde. Il restait à déterminer dans les propriétés du milieu dans lequel se propageait cette onde (voir l’ C’est ce que découvrirent les scientifiques de la fin du XIXème siècle (avec les travaux expérimentaux de Faraday) et Maxwell (en 1864) fournit une description théorique très détaillée des phénomènes électromagnétiques permettant de rendre compte à la fois des phénomènes électriques, magnétiques et de la propagation de la lumière.

C’est ce que découvrirent les scientifiques de la fin du XIXème siècle (avec les travaux expérimentaux de Faraday) et Maxwell (en 1864) fournit une description théorique très détaillée des phénomènes électromagnétiques permettant de rendre compte à la fois des phénomènes électriques, magnétiques et de la propagation de la lumière. Parmi les mystères de la fin du XIXème perdurait celui du rayonnement du corps noir : un corps chaud émet une lumière. Cette lumière est le fruit de l’interaction entre la matière et la lumière. A l’aide des modèles statistiques de la fin du XIXème siècle, on peut expliquer ce rayonnement mais on aboutit à ce qui fut appeler « la catastrophe ultraviolette ». En effet, les modèles de l’époque prévoyait un rayonnement infini dans le domaine de l’ultraviolet et des rayons X lorsqu’un corps est chauffé, en complète contradiction avec les résultats expérimentaux. Pour expliquer cela, Max Planck proposa en 1900 de quantifier l’interaction entre la matière et la lumière : les atomes échangeraient des « quantas » d’énergie avec l’onde lumineuse. Sa proposition est « ad hoc« , c’est à dire qu’elle permet de résoudre le problème de la catastrophe ultraviolette mais Planck n’explique pas l’origine de cette quantification.

Parmi les mystères de la fin du XIXème perdurait celui du rayonnement du corps noir : un corps chaud émet une lumière. Cette lumière est le fruit de l’interaction entre la matière et la lumière. A l’aide des modèles statistiques de la fin du XIXème siècle, on peut expliquer ce rayonnement mais on aboutit à ce qui fut appeler « la catastrophe ultraviolette ». En effet, les modèles de l’époque prévoyait un rayonnement infini dans le domaine de l’ultraviolet et des rayons X lorsqu’un corps est chauffé, en complète contradiction avec les résultats expérimentaux. Pour expliquer cela, Max Planck proposa en 1900 de quantifier l’interaction entre la matière et la lumière : les atomes échangeraient des « quantas » d’énergie avec l’onde lumineuse. Sa proposition est « ad hoc« , c’est à dire qu’elle permet de résoudre le problème de la catastrophe ultraviolette mais Planck n’explique pas l’origine de cette quantification. Le Français Albert Fert et l’Allemand Peter Grünberg ont reçu

Le Français Albert Fert et l’Allemand Peter Grünberg ont reçu  Pour enregistrer des informations sur une bande magnétique ou un disque dur on fait passer un petit courant électrique dans une bobine au-dessus d’un matériau particulier (ferromagnétique) qui est capable de se « magnétiser » lorsqu’il est soumis à un champ magnétique. A l’issu de ce processus, le matériau est constitué d’une série de petits aimants dirigés dans un sens ou un autre, c’est comme si l’on plaçait côte à côte des petits aimants présentant leur face Nord ou leurs face Sud.

Pour enregistrer des informations sur une bande magnétique ou un disque dur on fait passer un petit courant électrique dans une bobine au-dessus d’un matériau particulier (ferromagnétique) qui est capable de se « magnétiser » lorsqu’il est soumis à un champ magnétique. A l’issu de ce processus, le matériau est constitué d’une série de petits aimants dirigés dans un sens ou un autre, c’est comme si l’on plaçait côte à côte des petits aimants présentant leur face Nord ou leurs face Sud. Un petit point sur la nomenclature de chimie organique. Bien sûr, vous ne pouvez pas être interrogé sur ce point pour le bac (c’est une compétence de 1s et le bac ne concerne que les compétences exigibles au programme de terminale) mais vous devez savoir nommer les esters jusqu’à 5 atomes de carbone (voir p.102 du

Un petit point sur la nomenclature de chimie organique. Bien sûr, vous ne pouvez pas être interrogé sur ce point pour le bac (c’est une compétence de 1s et le bac ne concerne que les compétences exigibles au programme de terminale) mais vous devez savoir nommer les esters jusqu’à 5 atomes de carbone (voir p.102 du