Dans le cours de Terminale S, on apprend qu’il y a 3 sortes de radioactivité : ?, ?+ et ?–. Dans cet article du site techno-science.net, on apprend qu’un autre type de radioactivité est possible bien que très rarement observé : la radioactivité 2-protons. Celle-ci a été réalisé dernièrement dans les locaux du GANIL (Grand Accélérateurs National d’Ions lourds dont je vous recommande la visite virtuelle). Dans ce type de radioactivité, ce sont 2 protons qui sont émis. Elle est rarement observée car elle est issue de noyaux présentant un excès de protons. Ceux-ci sont très instables et difficile à synthétiser au laboratoire. En effet, le noyau est le siège de 2 interactions aux effets contraires :

Dans le cours de Terminale S, on apprend qu’il y a 3 sortes de radioactivité : ?, ?+ et ?–. Dans cet article du site techno-science.net, on apprend qu’un autre type de radioactivité est possible bien que très rarement observé : la radioactivité 2-protons. Celle-ci a été réalisé dernièrement dans les locaux du GANIL (Grand Accélérateurs National d’Ions lourds dont je vous recommande la visite virtuelle). Dans ce type de radioactivité, ce sont 2 protons qui sont émis. Elle est rarement observée car elle est issue de noyaux présentant un excès de protons. Ceux-ci sont très instables et difficile à synthétiser au laboratoire. En effet, le noyau est le siège de 2 interactions aux effets contraires :

- l’interaction forte qui assure la cohésion du noyau auxquels sont soumis les protons et neutrons,

- et l’interaction coulombienne (ou électrique) qui tend à repousser les protons entre eux.

Généralement les noyaux ont un excès de neutrons par rapport aux protons car cela permet d’éloigner les protons les uns des autres et donc de diminuer la répulsion électrique à laquelle ils sont soumis.

Généralement les noyaux ont un excès de neutrons par rapport aux protons car cela permet d’éloigner les protons les uns des autres et donc de diminuer la répulsion électrique à laquelle ils sont soumis.

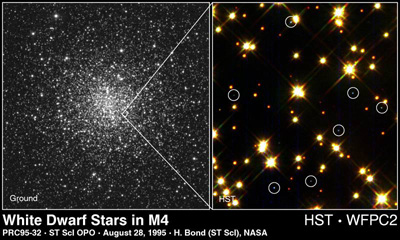

L’existence de la radioactivité 2-protons a été formulée théoriquement dans les années 60. Son observation expérimentale fournit de nouvelles données sur la façon dont les protons s’associent dans le noyau ce qui permet de mieux comprendre les processus à l’oeuvre dans la nucléosynthèse stellaire (les explosions nucléaires qui ont lieu au cœur des étoiles et des supernova). Rappelons que ce processus est à l’origine de tous les éléments chimiques de notre environnement : des atomes d’hélium jusqu’aux atomes d’uranium en passant par les atomes de carbone et d’oxygène qui nous constituent.

En complément de

En complément de  dommagent les molécules au cœur même de la cellule et cela peut avoir une influence sur son fonctionnement. Il existe également les rayonnements ionisants X ou ? qui sont des rayonnements électromagnétiques (

dommagent les molécules au cœur même de la cellule et cela peut avoir une influence sur son fonctionnement. Il existe également les rayonnements ionisants X ou ? qui sont des rayonnements électromagnétiques (

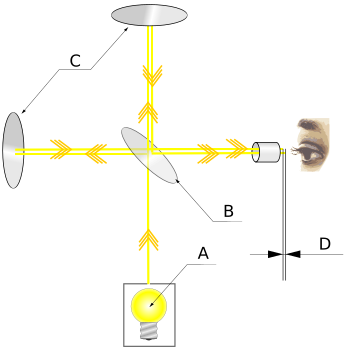

Cette question est cruciale dans tous les systèmes de pensées scientifique puisqu’elle permet de comprendre la façon dont on appréhende le monde. Ainsi, pour les atomistes grecs les objets émettaient des particules reproduisant la forme des objets de manière réduite dans notre oeil. Pour Euclide et les pythagoriciens, c’est notre oeil qui émet un « quid » et permet la vision. Cette description sera réfutée par Aristote car alors nous pourrions voir les objets la nuit, même en l’absence de lumière. Cependant, c’est du côté de l’Egypte que l’optique géométrique a été minutieusement étudiée avec les travaux d’Alhazen (Ibn Al-Haytham). Dans son livre « Les trésors de l’optique » (écrit entre 1015 et 1021, traduit en latin en 1572), il décrit la lumière de manière mécaniste, comme un flux de sphères pesantes, émis de sources ponctuelles en des rayons rectilignes, susceptibles d’être réfléchies, réfractées et perçues par l’oeil. Son livre traite également des lentilles (incluant l’oeil), des miroirs plans et curviligne, des couleurs et de la camera obscura (Une boîte noire percée d’un trou : le principe de la chambre noire). Son approche expérimentale et mathématique restera inégalé pendant 500 ans.

Cette question est cruciale dans tous les systèmes de pensées scientifique puisqu’elle permet de comprendre la façon dont on appréhende le monde. Ainsi, pour les atomistes grecs les objets émettaient des particules reproduisant la forme des objets de manière réduite dans notre oeil. Pour Euclide et les pythagoriciens, c’est notre oeil qui émet un « quid » et permet la vision. Cette description sera réfutée par Aristote car alors nous pourrions voir les objets la nuit, même en l’absence de lumière. Cependant, c’est du côté de l’Egypte que l’optique géométrique a été minutieusement étudiée avec les travaux d’Alhazen (Ibn Al-Haytham). Dans son livre « Les trésors de l’optique » (écrit entre 1015 et 1021, traduit en latin en 1572), il décrit la lumière de manière mécaniste, comme un flux de sphères pesantes, émis de sources ponctuelles en des rayons rectilignes, susceptibles d’être réfléchies, réfractées et perçues par l’oeil. Son livre traite également des lentilles (incluant l’oeil), des miroirs plans et curviligne, des couleurs et de la camera obscura (Une boîte noire percée d’un trou : le principe de la chambre noire). Son approche expérimentale et mathématique restera inégalé pendant 500 ans. Selon Newton, la lumière est constituée de corpuscules soumis à l’action des forces. Cela permet d’expliquer le comportement de la lumière comme on l’observe en optique géométrique : réfraction (changement de direction de la lumière lors de la traversée des milieux transparents), réflexion (comme pour un miroir) et modification du trajet de la lumière par les lentilles. En observant le phénomène de dispersion par un prisme (tel qu’il est étudié en classe de 2de), il en déduit que ces corpuscules sont de différents types, correspondant aux différentes couleurs perçues par l’oeil.

Selon Newton, la lumière est constituée de corpuscules soumis à l’action des forces. Cela permet d’expliquer le comportement de la lumière comme on l’observe en optique géométrique : réfraction (changement de direction de la lumière lors de la traversée des milieux transparents), réflexion (comme pour un miroir) et modification du trajet de la lumière par les lentilles. En observant le phénomène de dispersion par un prisme (tel qu’il est étudié en classe de 2de), il en déduit que ces corpuscules sont de différents types, correspondant aux différentes couleurs perçues par l’oeil. Ainsi, à partir du milieu du XIXème siècle, les scientifiques furent convaincus que la lumière était une onde. Il restait à déterminer dans les propriétés du milieu dans lequel se propageait cette onde (voir l’

Ainsi, à partir du milieu du XIXème siècle, les scientifiques furent convaincus que la lumière était une onde. Il restait à déterminer dans les propriétés du milieu dans lequel se propageait cette onde (voir l’ C’est ce que découvrirent les scientifiques de la fin du XIXème siècle (avec les travaux expérimentaux de Faraday) et Maxwell (en 1864) fournit une description théorique très détaillée des phénomènes électromagnétiques permettant de rendre compte à la fois des phénomènes électriques, magnétiques et de la propagation de la lumière.

C’est ce que découvrirent les scientifiques de la fin du XIXème siècle (avec les travaux expérimentaux de Faraday) et Maxwell (en 1864) fournit une description théorique très détaillée des phénomènes électromagnétiques permettant de rendre compte à la fois des phénomènes électriques, magnétiques et de la propagation de la lumière. Parmi les mystères de la fin du XIXème perdurait celui du rayonnement du corps noir : un corps chaud émet une lumière. Cette lumière est le fruit de l’interaction entre la matière et la lumière. A l’aide des modèles statistiques de la fin du XIXème siècle, on peut expliquer ce rayonnement mais on aboutit à ce qui fut appeler « la catastrophe ultraviolette ». En effet, les modèles de l’époque prévoyait un rayonnement infini dans le domaine de l’ultraviolet et des rayons X lorsqu’un corps est chauffé, en complète contradiction avec les résultats expérimentaux. Pour expliquer cela, Max Planck proposa en 1900 de quantifier l’interaction entre la matière et la lumière : les atomes échangeraient des « quantas » d’énergie avec l’onde lumineuse. Sa proposition est « ad hoc« , c’est à dire qu’elle permet de résoudre le problème de la catastrophe ultraviolette mais Planck n’explique pas l’origine de cette quantification.

Parmi les mystères de la fin du XIXème perdurait celui du rayonnement du corps noir : un corps chaud émet une lumière. Cette lumière est le fruit de l’interaction entre la matière et la lumière. A l’aide des modèles statistiques de la fin du XIXème siècle, on peut expliquer ce rayonnement mais on aboutit à ce qui fut appeler « la catastrophe ultraviolette ». En effet, les modèles de l’époque prévoyait un rayonnement infini dans le domaine de l’ultraviolet et des rayons X lorsqu’un corps est chauffé, en complète contradiction avec les résultats expérimentaux. Pour expliquer cela, Max Planck proposa en 1900 de quantifier l’interaction entre la matière et la lumière : les atomes échangeraient des « quantas » d’énergie avec l’onde lumineuse. Sa proposition est « ad hoc« , c’est à dire qu’elle permet de résoudre le problème de la catastrophe ultraviolette mais Planck n’explique pas l’origine de cette quantification. Ce mois-ci, la recherche propose un dossier complet sur les idées reçues sous la forme d’une dictionnaire. Petit extrait des idées reçues traitées :

Ce mois-ci, la recherche propose un dossier complet sur les idées reçues sous la forme d’une dictionnaire. Petit extrait des idées reçues traitées : Le Français Albert Fert et l’Allemand Peter Grünberg ont reçu

Le Français Albert Fert et l’Allemand Peter Grünberg ont reçu  Pour enregistrer des informations sur une bande magnétique ou un disque dur on fait passer un petit courant électrique dans une bobine au-dessus d’un matériau particulier (ferromagnétique) qui est capable de se « magnétiser » lorsqu’il est soumis à un champ magnétique. A l’issu de ce processus, le matériau est constitué d’une série de petits aimants dirigés dans un sens ou un autre, c’est comme si l’on plaçait côte à côte des petits aimants présentant leur face Nord ou leurs face Sud.

Pour enregistrer des informations sur une bande magnétique ou un disque dur on fait passer un petit courant électrique dans une bobine au-dessus d’un matériau particulier (ferromagnétique) qui est capable de se « magnétiser » lorsqu’il est soumis à un champ magnétique. A l’issu de ce processus, le matériau est constitué d’une série de petits aimants dirigés dans un sens ou un autre, c’est comme si l’on plaçait côte à côte des petits aimants présentant leur face Nord ou leurs face Sud.

Cet avertissement fait référence à la relativité restreinte (est-il nécessaire de présenter son père ?) dans lequel les équations du mouvement sont modifiées de sorte que mathématiquement, tout ce passe comme si la masse dépendait de la vitesse de l’objet. Ainsi, plus on se rapproche de la vitesse de la lumière, plus la masse semble augmenter, tendant vers l’infini lorsque la vitesse tend vers celle de la lumière. C’est ce qui permet d’affirmer qu’il est impossible à un objet massif d’atteindre la vitesse de la lumière puisque plus on se rapproche de la vitesse de la lumière, plus il faut communiquer d’énergie à l’objet pour le faire accélérer (on démontre qu’il faut une énergie infinie pour accélérer un objet à la vitesse de la lumière). C’est la raison pour laquelle on apprend en seconde que la vitesse de la lumière est une limite pour tous les objets massifs de l’univers. Ainsi lors du maniement d’un objet, prenez soin de ne pas l’amener à une valeur proche de celle de la lumière sans quoi, c’est le tour de rein assuré !

Cet avertissement fait référence à la relativité restreinte (est-il nécessaire de présenter son père ?) dans lequel les équations du mouvement sont modifiées de sorte que mathématiquement, tout ce passe comme si la masse dépendait de la vitesse de l’objet. Ainsi, plus on se rapproche de la vitesse de la lumière, plus la masse semble augmenter, tendant vers l’infini lorsque la vitesse tend vers celle de la lumière. C’est ce qui permet d’affirmer qu’il est impossible à un objet massif d’atteindre la vitesse de la lumière puisque plus on se rapproche de la vitesse de la lumière, plus il faut communiquer d’énergie à l’objet pour le faire accélérer (on démontre qu’il faut une énergie infinie pour accélérer un objet à la vitesse de la lumière). C’est la raison pour laquelle on apprend en seconde que la vitesse de la lumière est une limite pour tous les objets massifs de l’univers. Ainsi lors du maniement d’un objet, prenez soin de ne pas l’amener à une valeur proche de celle de la lumière sans quoi, c’est le tour de rein assuré ! Au fait, quelle est la valeur de la vitesse de la lumière ? 300 000 kilomètres par seconde. C’est une vitesse colossale à notre échelle (pour se donner un ordre d’idée, la vitesse la plus grande atteinte par les humains est celle des équipages d’Apollo qui lors de leur périple vers la Lune ont voyagé à 30 km/s soit dix mille fois moins que la vitesse de la lumière). Mais cette vitesse n’est pas si grande aux échelles de l’univers puisqu’il faut quand même 8 minutes à la lumière pour nous parvenir du soleil, 4 ans pour nous parvenir de l’étoile la plus proche et 100 milles ans pour traverser notre galaxie. Ramenons cette vitesse à la cadence de l’horloge d’un ordinateur. Celle-ci est de 2 GHz, soit 2 milliards d’impulsion par seconde. Quelle est la distance parcourue par la lumière le temps d’une impulsion ? 300 millions de mètres divisé par 2 milliards donne 15 cm. Ce qui veut dire que la lumière ne parcourt que 15 cm le temps d’un cycle d’horloge. Cette valeur explique que plus les ordinateurs « pensent vite », plus ils doivent être petit, sans quoi la communication entre les éléments risque de devenir une limite à leur vitesse de calcul.

Au fait, quelle est la valeur de la vitesse de la lumière ? 300 000 kilomètres par seconde. C’est une vitesse colossale à notre échelle (pour se donner un ordre d’idée, la vitesse la plus grande atteinte par les humains est celle des équipages d’Apollo qui lors de leur périple vers la Lune ont voyagé à 30 km/s soit dix mille fois moins que la vitesse de la lumière). Mais cette vitesse n’est pas si grande aux échelles de l’univers puisqu’il faut quand même 8 minutes à la lumière pour nous parvenir du soleil, 4 ans pour nous parvenir de l’étoile la plus proche et 100 milles ans pour traverser notre galaxie. Ramenons cette vitesse à la cadence de l’horloge d’un ordinateur. Celle-ci est de 2 GHz, soit 2 milliards d’impulsion par seconde. Quelle est la distance parcourue par la lumière le temps d’une impulsion ? 300 millions de mètres divisé par 2 milliards donne 15 cm. Ce qui veut dire que la lumière ne parcourt que 15 cm le temps d’un cycle d’horloge. Cette valeur explique que plus les ordinateurs « pensent vite », plus ils doivent être petit, sans quoi la communication entre les éléments risque de devenir une limite à leur vitesse de calcul. Peut-on libérer cette énergie ? En partie dans les réactions nucléaires, une partie infime mais qui suffit à expliquer les niveaux d’énergies atteint par les explosions nucléaires. Pour libérer totalement cette énergie il faut faire rencontrer à la matière son équivalent en antimatière. Cette rencontre se solde par une libération d’énergie sous forme de rayonnement gamma (le nom donné par les physiciens à la lumière de très courte longueur d’onde et de très haute énergie). C’est la façon dont est propulsé l’Enterprise dans Star Trek. Je tiens à vous rassurer tout de suite, il n’y a aucune chance que vous rencontriez au coin de rue votre double en anti-matière. En effet, les seules échantillons d’anti-matière que nous connaissions sont ceux que nous générons au sein des accélérateurs de particules. Pourquoi n’existe-t-il pas d’anti-matière naturelle ? Pour une raison toute simple : imaginons qu’un échantillon d’anti-matière existe quelque part sur notre planète, le moindre contact avec la matière se solderait par une libération colossale d’énergie. Il faudrait donc que cet échantillon soit isolé de toute matière, ce qui est impossible dans un environnement aussi dense que le notre.

Peut-on libérer cette énergie ? En partie dans les réactions nucléaires, une partie infime mais qui suffit à expliquer les niveaux d’énergies atteint par les explosions nucléaires. Pour libérer totalement cette énergie il faut faire rencontrer à la matière son équivalent en antimatière. Cette rencontre se solde par une libération d’énergie sous forme de rayonnement gamma (le nom donné par les physiciens à la lumière de très courte longueur d’onde et de très haute énergie). C’est la façon dont est propulsé l’Enterprise dans Star Trek. Je tiens à vous rassurer tout de suite, il n’y a aucune chance que vous rencontriez au coin de rue votre double en anti-matière. En effet, les seules échantillons d’anti-matière que nous connaissions sont ceux que nous générons au sein des accélérateurs de particules. Pourquoi n’existe-t-il pas d’anti-matière naturelle ? Pour une raison toute simple : imaginons qu’un échantillon d’anti-matière existe quelque part sur notre planète, le moindre contact avec la matière se solderait par une libération colossale d’énergie. Il faudrait donc que cet échantillon soit isolé de toute matière, ce qui est impossible dans un environnement aussi dense que le notre.