Oui je sais c’est partisan, mais bon, on ne va pas regarder l’eau monter en se croisant les doigts…

Catégorie : Comprendre

A quoi ressemble la terre lors d’une éclipse de soleil ?

L’ombre de la lune sur terre, le 11 Août 1999

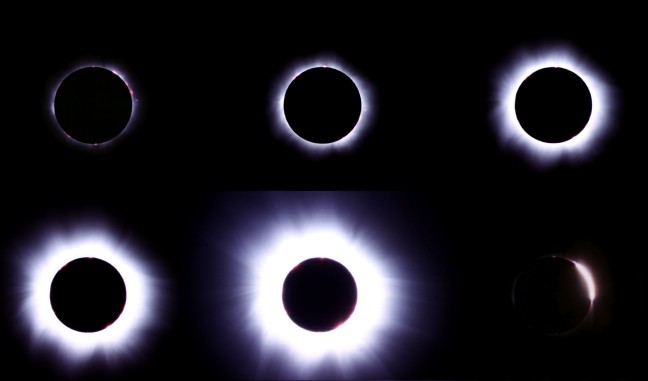

Cette photo prise de la station orbitale Russe Mir (quelques mois avant sa destruction) montre l’ombre de la lune sur la terre. Cette ombre se déplace à la vitesse de variant entre 1 706 km/h à l’équateur, et environ 3 380 km/h aux pôles (voir sur le site d’astrosurf). Le 11 Août 99, dans l’ombre de la lune, voici ce qu’on pouvait voir :

Le plus surprenant dans le phénomène de l’éclipse c’est que la lune occulte parfaitement le soleil. Cela veut dire que vus de la terre, la lune et le soleil ont le même diamètre.

Comme le soleil est 400 fois plus loin de la terre que la lune cela signifie qu’il est exactement 400 fois plus gros que la Lune. Étonnant, non ?

Qu’est-ce que la brisure de symétrie ?

Le prix Nobel de physique a été attribué cette année à 1 chercheur américain, M. et 2 chercheurs japonnais, M. « pour la découverte du mécanisme de brisure spontanée de symétrie en physique subatomique » (Réf : le monde – le site officiel des prix nobel).

Le prix Nobel de physique a été attribué cette année à 1 chercheur américain, M. et 2 chercheurs japonnais, M. « pour la découverte du mécanisme de brisure spontanée de symétrie en physique subatomique » (Réf : le monde – le site officiel des prix nobel).

Si le prix nobel de physique 2007 était un tant soit peu compréhensible par les non-initié à travers ses applications pratiques (voir Un prix Nobel Français dans notre ordinateur !) le prix Nobel 2008 semble beaucoup plus éloigné de nos préoccupations quotidiennes. De quoi s’agit-il ?

La symétrie et la physique

La symétrie des objets naturels (les flocons de neige, certaines fleurs) a quelque chose de fascinant car relativement rare. Lorsqu’on parle de symétrie en physique, il ne s’agit pas de celles des objets naturels. Il s’agit en fait de la symétrie des lois de la physique. Mais que vient faire la symétrie dans ces lois ?

La symétrie des objets naturels (les flocons de neige, certaines fleurs) a quelque chose de fascinant car relativement rare. Lorsqu’on parle de symétrie en physique, il ne s’agit pas de celles des objets naturels. Il s’agit en fait de la symétrie des lois de la physique. Mais que vient faire la symétrie dans ces lois ?

La symétrie pour les physiciens est la capacité à rester insensible à certaines transformations. Ainsi, un objet symétrique comme un carré, une sphère ou un flocon de neige n’est pas discernable de son reflet dans un miroir. Si l’on compare l’objet original et son reflet, on verra le même objet : on parle dans ces conditions de symétrie par réflexion dans un miroir.

Dans leur recherche de loi pour comprendre et prévoir le monde, les physiciens ont tendance à rechercher de telles symétries pour simplifier ces lois. C’est à dire qu’ils élaborent des lois qui sont inchangées lorsqu’on appliquent certaines transformations.

La symétrie par translation dans l’espace

Prenons un exemple simple de symétrie : la symétrie par translation dans l’espace. C’est une symétrie suivie par les lois de la physique. Celle-ci stipule que si l’on fait une certaine mesure ou qu’on applique une certaine loi quelque part dans l’espace les résultats que l’on obtiendrait ne dépendent pas de l’endroit où l’on fait la mesure. Cette loi parait bien étrange si l’on réfléchit un peu. En effet, si je mesure la valeur de la gravitation exercée par la Terre à Paris, je n’obtiendrais par la même valeur que si je faisais la mesure 400 km au-dessus du sol Parisien.

La symétrie par translation ne serait-elle pas vérifiée ? En réalité pour appliquer la symétrie par translation dans l’espace à la gravitation exercée par la terre, il faudrait également déplacer la terre de 400 km à la verticale de Paris. Dans ces conditions, la valeur de la gravitation sera la même.

Cela parait stupide d’inventer une loi qui dit que la valeur de la gravitation à Paris serait la même si on déplace la Terre dans l’espace. Quel est l’intérêt de chercher à vérifier une telle symétrie ? Cela permet de simplifier l’expression de la loi de gravitation : au lieu d’exprimer la loi de la gravitation à chaque position possible de la terre, on l’exprime d’une manière générale à une certaine distance de la terre. D’ailleurs, la preuve que la symétrie par translation d’espace est bien vérifiée est obtenue en se rappelant que la terre est toujours en mouvement autour du soleil et que s’il on fait la mesure de la gravitation Terrestre un certain jour à une certaine heure à Paris, on trouvera la même valeur un autre jour alors que nous sommes plusieurs millions de kilomètre plus loin.

La recherche de la symétrie dans les lois de la physique n’est donc pas une recherche esthétique de perfection mais plutôt une recherche de simplification de ces lois.

Quelles sont les symétries vérifiées par les lois de la physique ?

Il y a comme on vient de le voir la symétrie par translation dans l’espace. On admet généralement que la symétrie par translation de temps est également juste : les lois physiques vérifiée aujourd’hui était vrai hier et seront vrais demain (par exemple si l’on recréé les conditions du big bang dans le LHC ce qu’on trouvera était valable au moment du big bang). Bien entendu, cette loi est difficile à vérifier au-delà de la mémoire humaine mais elle est nécessaire pour décrire ce qu’a été le monde avant que la science ne commence à le décrire. Si cette symétrie était violée, alors on ne pourrait plus dire grand chose du passé puisque cela voudrait dire que les lois de la physique telles qu’elles s’expriment aujourd’hui n’étaient pas valable dans le passé.

Une symétrie fondamentale pour l’histoire de la physique est la symétrie de vitesse constante en ligne droite. Celle-ci affirme que toutes les lois physiques doivent être les même pour 2 observateurs en déplacement à vitesse constante l’un par rapport à l’autre. Autrement dit, si l’on se déplace à vitesse constante en ligne droite et que l’on ne peut pas observer l’environnement (imaginons par exemple un voyage interstellaire dans un vaisseau sans hublot), aucune expérience ne nous permet de déterminer si nous sommes en mouvement ou non. Cette symétrie est à l’origine de la relativité d’Einstein : c’est en réalisant qu’elle n’était pas vérifiée par les lois du mouvement de Newton appliquée à l’électromagnétisme qu’Einstein proposa de nouvelles lois du mouvement.

Un dernier exemple de symétrie qui fonctionne : les phénomènes ne sont pas modifiés lorsqu’on remplace un atome par un autre du même type.

Certaines symétries ne fonctionnent pas

Bien entendu, cela devient tout de suite plus intéressant (et du coup plus compliqué) lorsqu’on s’intéresse aux symétries qui ne sont pas vérifiées. On parle alors de brisure de symétrie.

La dépendance au changement d’échelle en est un exemple assez simple à se représenter. Imaginons un objet qui ait une taille de l’ordre de 1 m : une table en bois par exemple. Peut-on construire de la même façon une table avec une échelle différente ? Une table de 10 m ? Une table de 100 m ? Une table de 1 km ? Il est évident que non. Il arrivera un moment où le plateau de bois s’affaissera sous son propre poids. Les lois de la physique ne sont donc pas insensibles au changement d’échelle.

Une autre symétrie classique qui ne fonctionne pas est celle évoquée au début de cet article sur la réflexion par un miroir. C’est difficile à expliquer mais même si 99.9% des lois de la physique vérifient une symétrie droite-gauche, toutes ne le sont pas. En particulier, dans le monde des particules, la droite et la gauche est définie de manière absolue.

La brisure de symétrie Matière-antimatière

Une brisure de symétrie qui présente un intérêt tout particulier pour nous (et pour les lauréats du prix Nobel de physique 2008) est la brisure de symétrie Matière-Antimatière.

Toutes les particules qui constituent la matière ont une soeur jumelle « anti-particulaire ». Ainsi, il existe une particule nommée positon qui a toutes les caractéristiques d’un électron mais qui est chargé positivement. La rencontre entre une particule et son homologue anti-particule est détonante : les 2 entités disparaissent et libèrent toute leur énergie de masse (voir l’article “la masse de ce produit contient l’équivalent de 21 000 tonnes de TNT par gramme”). Conseil de physicien : si vous rencontrez un jour un extra-terrestre assurez-vous qu’il est fait de matière car une poignée de main entre un terrien-matière et un extraterrestre-antimatière ne donnerait qu’un flash intense d’énergie.

La symétrie matière-antimatière stipule qu’un monde fait d’antiparticule a exactement les mêmes caractéristiques qu’un monde fait de particules. C’est à dire que nos lois de la physique ne font pas la différence entre matière et anti-matière : pour notre extraterrestre-antimatière la tartine tombe toujours du côté beurré de sa planète-antimatière.

Au moment du big bang, il y a 14 Milliards d’année, la quantité de matière et d’antimatière était exactement la même. Comme nous habitons dans un univers fait de matière, il faut bien qu’il y ait une petite différence entre une particule et son homologue antiparticule. Cette différence accordant un petit avantage à la matière qui a pu perdurer au-delà des premières seconde du big bang. Les travaux des 3 Nobels de physique 2008 ont permis d’expliquer cette petite différence, cette brisure spontanée de symétrie matière-antimatière.

Comme l’ont dit les membres du comité Nobel « nous sommes tous des enfants de la brisure de symétrie » et cela valait bien un Nobel à ceux qui ont su l’expliquer.

![]() Références bibliographiques : chapitre « la symétrie en physique » in la nature de la physique – R. Feynman

Références bibliographiques : chapitre « la symétrie en physique » in la nature de la physique – R. Feynman

La première seconde planète extra-solaire photographiée ?

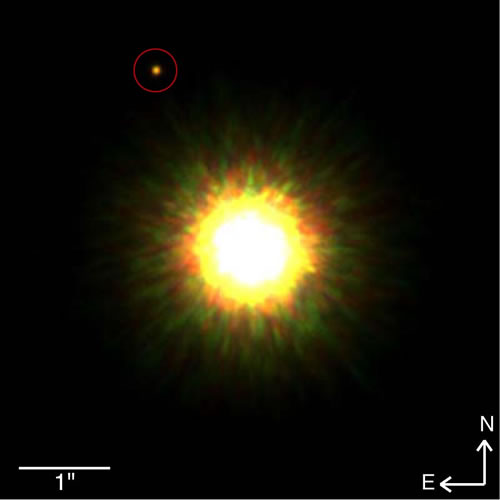

Cette photo serait la première photo d’une planète extra-solaire !

Cela reste encore a démontrer mais le cercle rouge de la photo ci-dessus serait une planète de masse 8 fois supérieure à Jupiter qui serait en orbite autour d’une étoile de type solaire à 330 fois la distance Terre-soleil. Celle-ci est située à 500 années-lumière de la terre.

Jusqu’à maintenant, toutes les preuves d’existence de planètes extra-solaires était indirectes. En effet, les astronomes détectent la présence de planète autour d’une étoile par les variations de luminosité de cette dernière : lorsque la planète passe devant l’étoile, elle intercepte un peu de sa lumière. Cette variation de luminosité est infime ce qui rend la détection de planète extra-solaire très difficile. Cette photo serait donc une première historique puisqu’on y voit un objet qui pourrait être une planète orbitant autour d’une étoile autre que le soleil !

Il reste encore à démontrer que c’est bien le cas, ce qui devrait prendre environ 2 ans : le temps de vérifier que cet objet se déplace bien avec son étoile.

![]() Petite correction Nov 2008 (voir les commentaires) : L’observatoire Européen ESO avait déjà pris une photo d’une planète extra-solaire en Avril 2004. A noter, cependant que l’étoile de la photo ci-dessus est une étoile type soleil alors que celle ci-contre est une jeune étoile faiblement lumineuse.

Petite correction Nov 2008 (voir les commentaires) : L’observatoire Européen ESO avait déjà pris une photo d’une planète extra-solaire en Avril 2004. A noter, cependant que l’étoile de la photo ci-dessus est une étoile type soleil alors que celle ci-contre est une jeune étoile faiblement lumineuse.

Source : Gemini observatory (pour la première photo), ESO (pour la seconde)

La résonance en vidéo

Pour obtenir le phénomène de résonance, il faut un excitateur et un résonateur. Le résonateur est un système oscillant à qui l’excitateur fournit de l’énergie par un couplage approprié. Pour que le phénomène de résonance ait lieu, il faut que la fréquence de l’excitateur soit approximativement égale à celle du résonateur.

Hum, tout cela est un peu difficile à comprendre théoriquement. Voyons ça en vidéo :

[kml_flashembed movie="http://www.dailymotion.com/swf/x4oira" width="425" height="335" wmode="transparent" /]

Bien sûr ce phénomène n’existe pas uniquement pour ces drôles d’objet de physiciens. Comme quasiment tout système matériel a une fréquence propre d’oscillation, il est possible de faire entrer en résonance toute sorte d’objet. Lorsqu »un objet est excité à sa fréquence de résonance, les oscillations peuvent prendre une telle amplitude que cela peut entraîner la destruction de l’objet.

Il y a bien sûr le classique verre de vin qui éclate s’il est soumis à sa fréquence de résonnance.

[kml_flashembed movie="http://www.youtube.com/v/17tqXgvCN0E" width="425" height="350" wmode="transparent" /]

Bien plus dramatique (mais heureusement sans mort), la résonance du pont de Tacoma :

[kml_flashembed movie="http://www.youtube.com/v/3mclp9QmCGs" width="425" height="350" wmode="transparent" /]

Et même les hélicoptères lorsqu’ils sont posés sur le sol ! Sur cette première séquence d’un épisode de Mac Gyver, on voit un hélicoptère qui entre en résonnance :

[kml_flashembed movie="http://www.youtube.com/v/6vICf8l-KV0" width="425" height="350" wmode="transparent" /]

Fort heureusement, la pilote a immédiatement décolé. Que ce serait-il passer s’il était rester au sol ?

[kml_flashembed movie="http://www.youtube.com/v/RihcJR0zvfM" width="425" height="350" wmode="transparent" /]

En réalité le phénomène de résonance est très courant. Dans le cas des tremblements de terre, c’est le phénomène de résonance qui induit l’effondrement des batiments : l’onde sismique agit comme un excitateur sur les batiments qui entrent en résonance.

Quel carburant pour la voiture du futur ?

Actuellement, nos voitures fonctionnent en effectuant une réaction d’oxydation des hydrocarbures présents dans l’essence :

Actuellement, nos voitures fonctionnent en effectuant une réaction d’oxydation des hydrocarbures présents dans l’essence :

Hydrocarbure + O2 ? CO2 + H2O

L’énergie libérée est le fruit des propriétés oxydantes de l’atmosphère et de l’énergie chimique emmagasinée dans les hydrocarbures. L’essence ordinaire est extraordinairement énergétique : 1 g d’essence libère 15 fois plus d’énergie qu’1 g d’explosif ! De plus cette énergie est contrôlable : contrairement aux explosifs, toute l’énergie n’est pas libérée instantanément.

Le problème avec ce mode de fonctionnement, c’est que d’une part, la réserve de pétrole n’est pas inépuisable et d’autre part, cela relâche du dioxyde de carbone (CO2) dans l’atmosphère ce qui contribue au réchauffement climatique.

Les biocarburants: une solution durable ?

La première idée qui vient à l’esprit c’est de remplacer l’essence par un carburant tout aussi énergétique mais renouvelable. Ainsi, certains constructeurs ont mis au point des voitures qui roulent au bioéthanol. Ce carburant est d’origine agricole. C’est à dire qu’on le produit à partir de colza ou d’autres huiles végétales.

La première idée qui vient à l’esprit c’est de remplacer l’essence par un carburant tout aussi énergétique mais renouvelable. Ainsi, certains constructeurs ont mis au point des voitures qui roulent au bioéthanol. Ce carburant est d’origine agricole. C’est à dire qu’on le produit à partir de colza ou d’autres huiles végétales.

Fondamentalement, cette idée est basée sur le même principe que l’essence : les organismes vivants synthétise des molécules susceptibles de libérer de l’énergie lors de l’oxydation par l’atmosphère. Pour l’essence, ces molécules ont été synthétisées il y a plusieurs millions d’années et sont en quantité limitée, pour les biocarburants ces molécules sont synthétisée chaque année et sont potentiellement infiniment renouvelable. La combustion des biocarburants produit aussi du CO2 mais celui-ci sera consommé par les champs servant à produire les biocarburants : le bilan est donc nul.

Bien sûr il y a un hic : jusqu’ici, l’agriculture était destinée à la nourriture. C’est donc une nouvelle utilisation de l’agriculture : manger ou conduire, il faut choisir ! La superficie des terres agricoles étant limitée, il faut augmenter les rendements de l’agriculture. Or cette augmentation des rendements a un coût énergétique : il faut consommer plus d’énergie pour produire plus (utilisation d’engrais, de tracteurs, etc.). Ainsi, produire des biocarburants consomme du pétrole et au final, il y a toujours relargage de CO2 par le pétrole.

et la voiture électrique ?

Puisque le carburant pose problème, utilisons des voitures électriques ! En effet, les moteurs électriques peuvent se montrer très performant et ne sont pas polluant. La production d’électricité est plus ou moins polluante mais on peut imaginer que des solutions durables respectueuses pour l’environnement vont être de plus en plus adoptées.

Seul petit problème technique : l’électricité ne se stocke pas en tant que tel. Il y a donc 2 solutions : soit la voiture fonctionne sur batterie (le stockage d’énergie est chimique) qui sont rechargées pendant la nuit, soit l’électricité est produite directement par la voiture.

La première solution présente de nombreux inconvénients : il faut garer sa voiture proche d’une prise électrique, les batteries sont encombrantes, chères, polluantes et doivent être changées régulièrement. La seconde solution parait donc plus adaptée à l’usage habituel que nous avons de la voiture mais comment produire de l’électricité directement dans la voiture ?

L’idée qui vient immédiatement à l’esprit est l’utilisation de panneaux solaires. En effet, l’énergie solaire est gratuite, directement accessible et éternellement renouvelable (tout du moins pour les 4 milliards d’années à venir). Encore une fois, il y a un hic : la terre reçoit du soleil environ 1000 Watt par m2 (1 kW/m2). Ainsi, il faut présenter une grande surface de panneau solaire pour faire avancer une voiture (voir l’image ci-contre). Une petite voiture développe environ 100 chevaux ce qui correspond à 100 kW. Il faudrait donc 100 m2 de panneaux solaires pour avoir la même puissance : il va falloir revoir la taille de nos routes !

L’idée qui vient immédiatement à l’esprit est l’utilisation de panneaux solaires. En effet, l’énergie solaire est gratuite, directement accessible et éternellement renouvelable (tout du moins pour les 4 milliards d’années à venir). Encore une fois, il y a un hic : la terre reçoit du soleil environ 1000 Watt par m2 (1 kW/m2). Ainsi, il faut présenter une grande surface de panneau solaire pour faire avancer une voiture (voir l’image ci-contre). Une petite voiture développe environ 100 chevaux ce qui correspond à 100 kW. Il faudrait donc 100 m2 de panneaux solaires pour avoir la même puissance : il va falloir revoir la taille de nos routes !

Une solution qui parait plus adaptée pour produire de l’électricité à l’échelle d’une voiture est l’utilisation de l’hydrogène.

L’hydrogène : la solution à tous nos problèmes énergétiques ?

Le dihydrogène (H2) réagit très violemment avec le dioxygène de l’air pour former de l’eau :

Le dihydrogène (H2) réagit très violemment avec le dioxygène de l’air pour former de l’eau :

2H2+O2 ? H2O

Cette réaction produit beaucoup d’énergie sans émission polluante. Cette énergie est parfaitement maitrisable dans une pile à combustible mais elle est plus difficile à maitriser en faisant le plein d’une voiture, par exemple. C’est l’un des nombreux problèmes avec une voiture à hydrogène : le plein doit se faire de sorte à ce que le dihydrogène ne soit jamais en contact avec l’air, sinon, c’est l’explosion assurée !

Pour mesurer, cette réactivité, on peut la comparer à l’essence : 1 g de dihydrogène est 2,5 fois plus énergétique qu’1 g d’essence. Avec un plein de 40 L d’essence, on peut faire environ 500 km. Cela correspond à 30 kg d’essence. Avec 30 kg d’hydrogène, on pourrait donc faire 1250 km ! Seulement, l’hydrogène n’est pas un liquide mais un gaz et 30 kg d’hydrogène occupe un très grand volume. Il est donc nécessaire de liquéfié l’hydrogène pour l’utiliser. C’est un autre problème avec l’hydrogène : on perd de l’énergie simplement à liquifier le gaz. Un autre problème est sa très faible densité, même lorsqu’il est liquide : sa densité est de 0,071g/cm3. Ainsi, 30 kg d’hydrogène ont un volume de plus de 400 L ! Encore une fois, il va falloir revoir la taille de nos voitures.

Mais le principal problème du dihydrogène est ailleurs : il n’existe pas à l’état naturel. Il faut le fabriquer. Comment ? C’est extrêmement simple, il suffit de faire la réaction inverse de celle qui a été notée plus haut :

2H2+O2 ? H2O

Si la première réaction produisait de l’énergie, celle-ci en consomme. Ainsi, toute l’énergie contenue dans l’hydrogène provient d’ailleurs : l’hydrogène n’est pas une source d’énergie, c’est juste un vecteur d’énergie. Si nos voitures devaient fonctionner à l’hydrogène, il faudrait trouver une autre source d’énergie qui permette de produire de l’hydrogène. Cela pourrait être des centrales électriques solaires (s’il n’était pas envisageable de fabriquer des voitures occupant une centaine de m2, il est parfaitement envisageable de faire des centrales électriques solaire de plusieurs hectares). Et l’économie du futur commence à se dessiner :

Des centrales solaires qui convertissent l’énergie solaire en énergie électrique. Celle-ci est utilisée pour produire du dihydrogène qui serait le carburant des transports en commun (du fait de sa faible densité, il faut prévoir de gros réservoirs de dihydrogène donc de gros véhicules). Il y a pour l’instant encore de nombreux obstacles à la réalisation de cette solution : rendement des panneaux solaires encore trop faibles, dangerosité du dihydrogène (stations services explosives, réservoirs qui pourraient exploser en cas d’accident), etc. mais la BMW Hydrogen 7 de série, qui sera commercialisé à partir de 2020 (voir sa fiche sur viamichelin) apparait comme l’une des premières briques de ce futur.

Pourquoi les spationautes flottent dans la navette spatiale ?

[youtube]https://www.youtube.com/watch?v=3bCoGC532p8[/youtube]

Le poids, la masse, la gravité

Si les photos et vidéos d’astronautes en orbite autour de la terre sont si fascinantes c’est parce qu’ils sont manifestement dans une situation impossible à vivre sur terre. Quoique nous fassions, nous retombons toujours sur le sol car la terre exerce une force qui nous attire. Celle-ci porte un nom : c’est le poids. Attention, il y a parfois une confusion entre poids et masse. Cela vient de l’imprécision du langage quotidien qui amalgame les deux. En effet, la masse correspond à la quantité de matière, elle s’exprime en kg tandis que le poids correspond à la force exercée par la terre, elle s’exprime donc en Newton (l’unité des forces). Bien entendu, les deux notions sont reliées puisque plus il y aura de masse (donc de quantité de matière), plus la force exercée par la terre sera élevée. D’ailleurs cela se traduit par une équation : P=m.g c’est à dire que le poids est proportionnel à la masse. La constante de proportionalité g est appelée constante gravitationnelle, elle vaut 9,8 N/kg (dans la suite, on prendra une valeur égale à 10). Ainsi, un spationaute de masse 80 kg subira à la surface de la terre un poids de 80.10=800 N. lorsque son médecin lui demande son poids il devrait répondre 800 N et non pas 80 kg.

La décroissance de g lorsqu’on s’éloigne de la terre

Cette constante gravitationnelle g dépend en fait de l’endroit où l’on se trouve. Plus on est proche de la terre, plus elle est élevée (la valeur 9,8 est une valeur moyenne). C’est une constante qui dépend également de la planète où l’on se trouve. Sur la Lune, sa valeur est 6 fois plus faible. Ainsi notre spationaute de 80 kg, sur la lune, serait soumis à une force de 130 N. Ayant développé une musculature pour soulever 800 N sur Terre, il pourra s’amuser à faire des galipettes. Comme on le voit sur cette vidéo de la nasa (rappelons que la combinaison des spationautes est lourde, de l’ordre de 100 kg…).

[kml_flashembed movie="http://www.youtube.com/v/kbxkcEW3UYM" width="425" height="350" wmode="transparent" /]

Mais revenons à notre spationaute qui flotte dans la navette spatiale, serait-ce parce qu’à cette altitude, il n’y a plus de gravité ? Si l’on fait le calcul, on trouve que g à l’altitude de vol de la navette spatiale (400 km) est de 8,7 N/kg. Notre spationaute est donc bien attiré par la terre puisque son poids à cette altitude est de 700 N (ce qui est même supérieur à la force éprouvée sur la Lune), alors pourquoi flotte-t-il ?

l’inertie et l’accélération de pesanteur

Pour répondre à cette question, il faut s’intéresser à la chute libre. Comme bien souvent dans un problème de physique, la réponse n’est pas directement là où on le croit… Pour comprendre « Pourquoi un spationaute flotte dans l’espace ? » il faut se poser la question « Si deux boules de masses différentes sont lâchées à une hauteur de disons 10 m du sol, laquelle arrivera la première ? la plus lourde ou la plus légère ? ». Réponse que tout le monde connait : elles arriveront en même temps. Voilà une réponse intéressante. Tout le monde la connait mais peu de gens la comprennent (je prend pour preuve le nombre de fois où en fin de repas, on m’a posé la question « Ah ben tiens, toi qui est prof de physique, tu vas pouvoir me dire pourquoi c’est pas la plus lourde qui arrive en premier ? »). Essayons de comprendre pourquoi.

1er point : comme on l’a vu, plus un objet est lourd, plus la terre l’attire (rappelons-nous P=m.g). Sur ce point, on est bien d’accord.

2nd point : plus un objet est lourd, plus il est difficile de le mettre en mouvement. Ce dernier point est bien souvent oublié, pourtant, il est incontestable qu’il est plus difficile de pousser une grosse berline qu’une twingo, et cela ne vient pas seulement des frottements : plus la masse est grande, plus l’objet à d’inertie, plus il est difficile à mettre en mouvement.

Il se trouve que ces deux faits se compensent exactement : l’objet le plus lourd est soumis à une plus grande force mais il est plus difficile à mettre en mouvement que l’objet le plus léger. Ainsi, les 2 objets ont le même mouvement, en l’occurrence, un mouvement accéléré. D’ailleurs la valeur de l’accélération est exactement égale à la valeur de la constante gravitationnelle. Ainsi, tout objet livré à lui-même au voisinage de la terre subit une accélération égale à 10 m/s² cela veut dire que tout objet en chute libre voit sa vitesse augmenter vers le bas de 10 m/s (36 km/h) à chaque seconde.

la chute libre

Imaginons maintenant que nous soyons dans un ascenseur dont le câble lâche. L’ascenseur se met à tomber en accélérant. S’il était initialement au repos, il aura une vitesse de 36 km/h au bout d’une seconde. Tout comme nous dans l’ascenseur qui aurons le même mouvement. Nous chuterons donc avec l’ascenseur en ayant toujours la même vitesse que lui. Si l’on se prenait en photo à ce moment…il n’y a guère que les physiciens pour penser à se prendre en photo dans un ascenseur en chute libre, tout être normalement constitué n’aurait qu’une seule activité : crier… mais bon, imaginons que nous aurions l’idée de nous prendre en photo, alors nous semblerions flotter dans l’ascenseur ! Comme l’astronaute dans la navette spatiale. Ainsi, les astronautes ne flottent pas réellement, ils sont simplement en train de tomber dans un mouvement exactement analogue à celui de la navette spatiale. Ce qui donne cette sensation qu’ils sont en apesanteur (non soumis à la pesanteur). En réalité, ils sont toujours soumis à la pesanteur : celle-ci les maintient dans un mouvement circulaire uniforme autour de la terre. S’il n’y avait pas de pesanteur, ils partiraient tout droit, vers l’infini est au-delà !

Annexe : le calcul de la constante gravitationnelle à 400 km de la surface terrestre.

De l’expression de l’interaction gravitationnelle F=G.mA.mB/dAB² on déduit g=G.M/d² où M est la masse de la planète et d la distance au centre de la planète. Dans les conditions de la navette spatiale : M = 5,98.10^24 kg et d = Rayon de la terre + altitude = 6,38.10^6+400.10^3 m ce qui donne g=8,7 N/kg.

[youtube]https://www.youtube.com/watch?v=RmV90BmMNMg[/youtube]

du femtomètre aux années-lumière

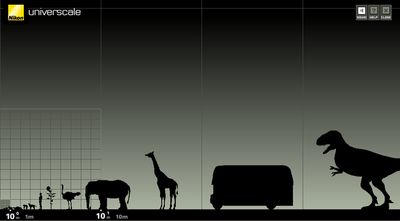

Nikon propose sur son site anglais une belle animation pour illustrer les différentes échelles de notre univers : universcale. Cela rappelle le film sur les puissances de 10.

L’animation est en anglais, mais la navigation est assez facile : en cliquant sur les textes, ceux-ci disparaissent. Pour « zoomer » ou « dézoomer », il suffit d’utiliser la molette centrale de sa souris.

Elle illustre parfaitement le caractère « lacunaire » de la matière : il y a parfois de grandes plages d’échelles sans aucun objet. Par exemple, la taille de notre galaxie est de 1021m et la taille d’une nébuleuse est de l’ordre de 1018 m. On ne connait pas d’objet dont la taille est intermédiaire. De la même façon, notre système solaire s’étend sur 1014 m et contient une étoile de 109 m et des planètes de l’ordre de 108 m mais il n’y a pas d’objet entre 109 m et 1014 m. Cette structure lacunaire se retrouve également au niveau microscopique. En effet, à partir de 10-10 m, il ne semble plus y avoir « d’objet » mais en continuant à zoomer, on finit par trouver le noyau de l’atome à 10-15 m (cela répond aux interrogations de Lélia dans les commentaires de « ce produit est en fait constitué à 99,9999999999 % d’espace vide« ). La diversité d’objet que nous connaissons de 105 m à 10-9 m n’existe donc pas à toutes les échelles.

Une centrale nucléaire peut-elle exploser comme une bombe nucléaire ?

Explications en vidéo

Une centrale nucléaire peut-elle exploser comme… par lewebpedagogique

Centrales nucléaires et bombes nucléaires ont en commun de tirer parti de l’extraordinaire énergie contenue dans le noyau des atomes à travers des réactions nucléaires de fission (voir les articles « Ce produit est constitué de 99,999999 % de vide » et « Ce produit contient l’équivalent de 21 000 tonnes de TNT« ). On distingue 2 types de réactions nucléaires : la fusion et la fission. Dans la fusion, 2 petits noyaux se réunnissent pour former un gros noyau alors que dans la fission, c’est un gros noyau qui se désintègre en plusieurs petits noyaux : généralement 2 noyaux + 2 ou 3 neutrons comme on peut le voir sur la figure ci-contre où un noyau d’Uranium 236 (contenant 236 particules) se désintègre pour former un noyau de Krypton , de Baryum 141 et 3 neutrons. L’Uranium 236 est un isotope de l’Uranium : il contient 92 protons (comme tous les noyaux d’uranium) et 236-92 = 144 neutrons. On ne le trouve pas naturellement dans la nature puisque les minerais d’uranium sont constitués à 99,3 % d’Uranium 238 (92 protons et 146 neutrons) et 0,7 % d’Uranium 235 (92 protons et 143 neutrons). Pour former un noyau d’Uranium 236, il faut qu’un noyau d’Uranium 235 capte un neutron comme cela est indiqué sur la figure ci-dessous :

Centrales nucléaires et bombes nucléaires ont en commun de tirer parti de l’extraordinaire énergie contenue dans le noyau des atomes à travers des réactions nucléaires de fission (voir les articles « Ce produit est constitué de 99,999999 % de vide » et « Ce produit contient l’équivalent de 21 000 tonnes de TNT« ). On distingue 2 types de réactions nucléaires : la fusion et la fission. Dans la fusion, 2 petits noyaux se réunnissent pour former un gros noyau alors que dans la fission, c’est un gros noyau qui se désintègre en plusieurs petits noyaux : généralement 2 noyaux + 2 ou 3 neutrons comme on peut le voir sur la figure ci-contre où un noyau d’Uranium 236 (contenant 236 particules) se désintègre pour former un noyau de Krypton , de Baryum 141 et 3 neutrons. L’Uranium 236 est un isotope de l’Uranium : il contient 92 protons (comme tous les noyaux d’uranium) et 236-92 = 144 neutrons. On ne le trouve pas naturellement dans la nature puisque les minerais d’uranium sont constitués à 99,3 % d’Uranium 238 (92 protons et 146 neutrons) et 0,7 % d’Uranium 235 (92 protons et 143 neutrons). Pour former un noyau d’Uranium 236, il faut qu’un noyau d’Uranium 235 capte un neutron comme cela est indiqué sur la figure ci-dessous :

Réaction en chaîne

Ainsi, la réaction nucléaire au coeur d’une centrale nucléaire comme d’une bombe nucléaire est du type :

1 noyau d’Uranium 235 + 1 neutron ? 2 noyaux plus petits + 2 à 3 neutrons

Supposons que 2 neutrons émis par la désintégration d’un noyau d’Uranium 235 rencontrent 2 noyaux d’uranium 235. Ceux-ci vont à nouveau se désintégrer donnant naissance à 2×2=4 nouveaux neutrons eux-mêmes susceptibles de rencontrer 4 autres noyaux d’uranium 235 qui eux-même vont produire 4×2=8 nouveaux neutrons susceptible de continuer le processus (voir le schéma ci-contre) : c’est une réaction en chaîne. Sachant qu’à chaque fois que ce processus à lieu, il libère une très grande énergie, on comprend qu’une réaction nucléaire libère une quantité colossale d’énergie en un temps extrêmement court : 10 kg d’Uranium 235 sont complètement désintégrés en seulement 84 étapes comme celle qui vient d’être décrite !

Supposons que 2 neutrons émis par la désintégration d’un noyau d’Uranium 235 rencontrent 2 noyaux d’uranium 235. Ceux-ci vont à nouveau se désintégrer donnant naissance à 2×2=4 nouveaux neutrons eux-mêmes susceptibles de rencontrer 4 autres noyaux d’uranium 235 qui eux-même vont produire 4×2=8 nouveaux neutrons susceptible de continuer le processus (voir le schéma ci-contre) : c’est une réaction en chaîne. Sachant qu’à chaque fois que ce processus à lieu, il libère une très grande énergie, on comprend qu’une réaction nucléaire libère une quantité colossale d’énergie en un temps extrêmement court : 10 kg d’Uranium 235 sont complètement désintégrés en seulement 84 étapes comme celle qui vient d’être décrite !

Masse critique

L’emballement ou non de la réaction dépend de la rencontre ou non entre les noyaux produits par la désintégration et d’autres noyaux d’Uranium 235. S’il n’y a pas assez de noyaux d’Uranium 235, les neutrons produits vont pouvoir s’échapper de l’échantillon d’uranium 235 et la réaction en chaîne ne se fera pas. Il y a donc une masse critique d’uranium 235 pour laquelle la réaction en chaîne se réalise. En théorie cette masse est de 200 kg d’Uranium 235. Durant la seconde guerre mondiale, il n’était pas possible de réunir une telle masse d’uranium 235 et les scientifiques Nazis ont renoncé à développer une bombe nucléaire pour cette raison. Cependant, le groupe de chercheur réuni par le gouvernement Américain à Los Alamos pour élaborer la bombe nucléaire réussirent à réduire cette masse critique en entourant l’uranium 235 de réflecteur à neutrons, renvoyant les neutrons émis vers le centre du « combustible ». Cela leur permit de réduire la valeur de la masse critique à 15 kg d’Uranium 235.

Enrichissement de l’uranium

Comme nous l’avons vu, à l’état naturel, les minerais d’Uranium sont constitué à seulement 0,7 % d’Uranium 235. Cette concentration est bien trop faible pour initier la réaction en chaîne. Il est nécessaire d’enrichir l’Uranium pour augmenter la concentration en Uranium 235. Pour un usage militaire (dans les bombes nucléaires), il faut 80 % d’Uranium 235. L’enrichissement de l’uranium est très complexe, très long et très coûteux, il est nécessaire de séparer les noyaux d’Uranium 235 des noyaux d’Uranium 238. C’est la raison pour laquelle, bien que la technologie des bombes nucléaires soit relativement simple à comprendre sur le papier, tous les pays ne sont pas capables de construire une bombe nucléaire. La photo ci-contre montre un des instrument retrouvé en Irak qui permet d’enrichir l’uranium.

Comme nous l’avons vu, à l’état naturel, les minerais d’Uranium sont constitué à seulement 0,7 % d’Uranium 235. Cette concentration est bien trop faible pour initier la réaction en chaîne. Il est nécessaire d’enrichir l’Uranium pour augmenter la concentration en Uranium 235. Pour un usage militaire (dans les bombes nucléaires), il faut 80 % d’Uranium 235. L’enrichissement de l’uranium est très complexe, très long et très coûteux, il est nécessaire de séparer les noyaux d’Uranium 235 des noyaux d’Uranium 238. C’est la raison pour laquelle, bien que la technologie des bombes nucléaires soit relativement simple à comprendre sur le papier, tous les pays ne sont pas capables de construire une bombe nucléaire. La photo ci-contre montre un des instrument retrouvé en Irak qui permet d’enrichir l’uranium.

Dans les centrales nucléaires, pour que la réaction nucléaire ne s’emballent pas, on fait en sorte que les neutrons produis par la désintégration d’un noyau ne rencontre pas plus d’un noyau d’Uranium 235. Pour cela, on utilise un minerai à 3 % seulement et on ralentit les neutrons à l’aide d’un modérateur (de l’eau ou de l’eau lourde et des barres de carbones graphites) comme on peut le voir sur la photo ci-contre, où les barres de combustibles (à droite) sont au fond d’une piscine. Les neutrons produit par la réaction nucléaire sont ralentis par l’eau et empêche l’emballement de la réaction. En effet, en cas d’erreur de manipulation et d’emballement de la réaction, la lenteur des neutrons limite la taille de l’explosion. A une température de quelques milliers de degrés, les atomes bougent plus vite que les neutrons et ceux-ci ne leur rentrent plus dedans : la réaction en chaine est stoppée. L’énergie produite peut effectivement faire exploser le réacteur mais à des niveaux d’énergie comparable à celle des explosions conventionnelles, c’est à dire des millions de fois plus petite qu’une explosion nucléaire. Contrôler une centrale nucléaire n’est pas du tout identique à contrôler une bombe nucléaire (par construction incontrôlable une fois la réaction en chaine activée).

Dans les centrales nucléaires, pour que la réaction nucléaire ne s’emballent pas, on fait en sorte que les neutrons produis par la désintégration d’un noyau ne rencontre pas plus d’un noyau d’Uranium 235. Pour cela, on utilise un minerai à 3 % seulement et on ralentit les neutrons à l’aide d’un modérateur (de l’eau ou de l’eau lourde et des barres de carbones graphites) comme on peut le voir sur la photo ci-contre, où les barres de combustibles (à droite) sont au fond d’une piscine. Les neutrons produit par la réaction nucléaire sont ralentis par l’eau et empêche l’emballement de la réaction. En effet, en cas d’erreur de manipulation et d’emballement de la réaction, la lenteur des neutrons limite la taille de l’explosion. A une température de quelques milliers de degrés, les atomes bougent plus vite que les neutrons et ceux-ci ne leur rentrent plus dedans : la réaction en chaine est stoppée. L’énergie produite peut effectivement faire exploser le réacteur mais à des niveaux d’énergie comparable à celle des explosions conventionnelles, c’est à dire des millions de fois plus petite qu’une explosion nucléaire. Contrôler une centrale nucléaire n’est pas du tout identique à contrôler une bombe nucléaire (par construction incontrôlable une fois la réaction en chaine activée).

Il y a bien de réels dangers dans l’utilisation des réacteurs nucléaires (dont celui de la fonte du réacteur en cas de fuite sur le système de refroidissement, avec le risque de dispersion de matériaux radioactifs dans l’environnement) mais une explosion du type bombe nucléaire n’en fait pas parti.

Et le plutonium ?

La fusion de noyaux de Plutonium est également utilisée dans les bombes nucléaires. Celle-ci est plus efficace que celle de l’uranium car elle produit plus de neutrons. La masse critique de Plutonium est donc plus faible que celle d’Uranium : 5 kg de Plutonium suffit là il en fallait 15 avec l’Uranium (en 1945, la bombe qui a explosé sur Hiroshima était une bombe à Uranium tandis que celle qui a explosé à Nagasaki était une bombe à Plutonium). Parmi les déchets de combustible des réacteurs nucléaires, on trouve beaucoup de Plutonium. En effet, lorsque l’uranium 238 (qui constitue la majorité des barres de combustible) est frappé par un neutron, il se transforme en noyau d’Uranium 239, élément radioactif (temps de demi-vie de 23 min) qui se désintègre en Neptunium 239, lui-même radioactif (demi-vie 2,3 jours) pour donner les fameux noyaux de plutonium 239.

Ainsi, l’enjeu du nucléaire civil dépasse bien souvent le simple accès aux ressources énergétique car lorsqu’un pays se dote d’une centrale nucléaire, il se munit par la même occasion d’une source de Plutonium, susceptible d’être recyclé à des fins militaires : la frontière entre nucléaire civil et nucléaire militaire est ténue comme l’illustre cet extrait d’un article publié dans le monde du 16 Novembre 2007 :

Le rapport remis, vendredi 16 novembre, par le directeur de l’Agence internationale de l’énergie atomique (AIEA), Mohamed El Baradei, ne permet pas de savoir si le programme nucléaire iranien est civil ou militaire. Guetté comme une étape cruciale dans la crise diplomatique autour du nucléaire iranien, le rapport que le directeur de l’Agence internationale de l’énergie atomique (AIEA), Mohamed El Baradei, a remis, vendredi 16 novembre, est un document lourd d’ambiguïtés, susceptible de donner lieu à des interprétations divergentes, et donc d’attiser les tiraillements à l’ONU à propos de nouvelles sanctions contre Téhéran.

Les effets biologiques de la radioactivité II : les effets à long terme

Dans l’article précédent, nous avons vu qu’au quotidien nous sommes soumis à une dose diffuse de radioactivité, trop faible pour avoir des conséquence à court terme. Quels sont les effets sur le long terme de ces doses diffuses ?

Ceux-ci sont plus délicats à quantifier que les effets à court terme. Je suivrais pour en expliquer les effets le raisonnement de Richard Muller dans son cours physics for future presidents. On considère qu’une exposition à 25 Sv a 100 % de chances d’induire un cancer. Cela peut sembler paradoxale puisqu’on a vu que l’on meurt très rapidement « par empoisonnement » à partir de 10 Sv. La solution de ce paradoxe est dans ce qu’on appelle l’hypothèse linéaire : on suppose qu’il est équivalent de soumettre 1 personne à 25 Sv et 25 000 personnes à 1 mSv. Cela peut sembler absurde et cette hypothèse est souvent remise en cause par les spécialistes. Cependant, il faut bien garder à l’esprit que l’apparition d’un cancer n’est pas « systématique » et qu’il faut raisonner de manière statistique. En application du principe de précaution, les organismes nationaux et internationaux utilisent cette hypothèse pour quantifier les conséquences des expositions aux faibles doses de radioactivité. Sans rentrer dans la controverse (parfois violente), nous retiendrons cette hypothèse et allons en explorer les conséquences.

Retenons : pour 25 000 personnes soumises à 1 mSv, statistiquement, 1 personne développera 1 cancer

On pourra également retenir que l’exposition à 1 mSv augmente notre probabilité d’avoir un cancer de 1/25000 soit 0,004 %.

Voyons les conséquences de cette hypothèse. En France, la dose environnementale annuelle reçue du fait de la radioactivité naturelle et médicale est de 3 à 4 mSv par individus (avec de fortes variations selon l’endroit où l’on vit, son métier, etc.). Soit une dose de 3,5×60 millions = 210 millions mSv reçue annuellement en France. Cela provoque donc à priori 210 millions divisé par 25 000 = 8 400 cancers par an. Ce chiffre peut sembler énorme mais il est encore loin derrière les 66 000 décès par an lié au tabagisme. Il est également à comparer à la probabilité de mourir d’un cancer qui est de l’ordre de 25 % (moins pour les femmes et plus pour les hommes). 8400 personnes souffrant d’un cancer représente 0,014 % de la population totale. Cela veut donc dire que l’environnement radioactif participe de 0,014 % au 25 % de risque d’avoir un cancer.

Autre exemple d’application de l’hypothèse énoncée plus haut : chacun d’entre nous est radioactif (du fait entre autre du carbone 14 et du potassium 14). La dose reçue est d’environ 0,25 mSv/an. Le risque de cancer par auto-contamination est donc de 0,25×0,004=0,001 %. Ce chiffre est insignifiant devant le risque naturel. Cependant, il signifie malgré tout qu’environ 600 personnes développent un cancer auto-induit en France chaque année !

Combien de personnes sont mortes à Hiroshima des conséquences à long terme de la radioactivité ? Selon Richard Muller, moins de 1 %. Cela peut paraitre paradoxale mais voyons le raisonnement : à part les personnes loin du centre de l’explosion, très peu de personnes ont survécus aux effets conventionnels de la bombe (effet thermique de l’explosion sous la forme d’une boule de feu) et aux effets à court terme d’une exposition à la radioactivité. Les meilleurs estimations donnent 52 000 survivants qui ont reçu une dose moyenne de 200 mSv. Cela induit que 200×52000=10 400 000 mSv ont été reçues. En divisant par 25 000 on arrive à 416 cancers soit 0,8 % des 52 000 survivants. On estime le nombre de victimes d’Hiroshima entre 50 000 et 150 000, il y a donc eu moins de 1 % de mort par cancer du fait de la bombe.

Un dernier exemple très controversé, ce qui nous permettra de voir les limites de ce raisonnement : les conséquences de l’accident de Tchernobyl. En 1986, l’un des réacteur de la centrale nucléaire de Tchernobyl explose du fait d’une succession d’erreurs humaines (voir le descriptif de l’accident sur le site astrosurf). Des matériaux radioactifs furent dégagés dans l’atmosphère et se dispersèrent dans toute l’europe (voir l’image satellite ci-contre). On estime que l’humanité a reçu une dose de 600 000 000 mSv. Cet accident aurait donc induit 600 000 000/25 000 = 24 000 cancers (il s’agit d’une estimation grossière, qui relève plus de l’ordre de grandeur que du décompte exact des cancers). Mais ses conséquences ne s’arrêtent pas là. En effet, ces considérations statistiques ne décompte que les cancers directement induits par la radioactivité et ne prennent pas en compte le processus de mutation génétique (pathologies cardiaques, diabètes, naissances difformes, etc.) qui peut se répercuter de générations en générations, affectant plus particulièrement les enfants, 20 ans après la catastrophe (voir par exemple cet article sur le site d’UNICEF).

Un dernier exemple très controversé, ce qui nous permettra de voir les limites de ce raisonnement : les conséquences de l’accident de Tchernobyl. En 1986, l’un des réacteur de la centrale nucléaire de Tchernobyl explose du fait d’une succession d’erreurs humaines (voir le descriptif de l’accident sur le site astrosurf). Des matériaux radioactifs furent dégagés dans l’atmosphère et se dispersèrent dans toute l’europe (voir l’image satellite ci-contre). On estime que l’humanité a reçu une dose de 600 000 000 mSv. Cet accident aurait donc induit 600 000 000/25 000 = 24 000 cancers (il s’agit d’une estimation grossière, qui relève plus de l’ordre de grandeur que du décompte exact des cancers). Mais ses conséquences ne s’arrêtent pas là. En effet, ces considérations statistiques ne décompte que les cancers directement induits par la radioactivité et ne prennent pas en compte le processus de mutation génétique (pathologies cardiaques, diabètes, naissances difformes, etc.) qui peut se répercuter de générations en générations, affectant plus particulièrement les enfants, 20 ans après la catastrophe (voir par exemple cet article sur le site d’UNICEF).

Il est évident que les conséquences d’une radio-exposition sont complexes. Inhaler des poussières radio-actives n’a pas les mêmes conséquences qu’une exposition à la radioactivité par la peau. Certains organes sont plus sensibles que d’autres, certains sujet également (en particulier les enfants, les adolescents et les femmes enceintes). Les considérations statistiques ne prennent pas en compte les individus (par définition) et lorsqu’on dit que telle exposition induit 100 cancers de plus que la normalité ce qui est insignifiant statistiquement, c’est toujours 100 cancers de trop, surtout si un choix politique permet de les éviter. Néanmoins, ces estimations permettent de donner une idée des conséquences d’une exposition à une faible dose de radioactivité. Sans minimiser les effets d’une catastrophe du type Tchernobyl, elles permettent de relativiser les effets de la radioactivité naturelle : vivre dans une belle maison en granit rose a certainement beaucoup plus de conséquences positives que de conséquences négatives liées à l’activité radioactive du granit (qui contient des traces d’uranium).

Bibliographie:

- Un dossier très riche sur futura-sciences

- Le chapitre radioactivity du cours « Physics for future president » à Berkeley de R. Muller

- Le dossier Tchernobyl d’astrosurf.