« La mécanique de Newton » est le premier chapitre de la mécanique. Il revient sur les 3 lois de Newton déjà étudiées en première S tout en précisant l’expression vectorielle de la seconde loi grâce à une définition rigoureuse de l’accélération. Les chapitres suivants s’attacheront à appliquer ces trois lois dans différentes situations.

Note : dans l’article qui suit, les vecteurs sont notés en gras.

Voici ce que le programme exige que vous sachiez sur cette partie :

Choisir un système. Choisir les repères d’espace et de temps.

Pour un vrai problème de physique (pas un problème pré-mâché de sujet de bac), le choix du système est plus délicat que ce qu’il peut y paraître à priori. Cependant dans la plupart des problèmes de bac, le système est clairement défini par le sujet. Ainsi, il ne faut pas s’en faire, juste bien se rappeler lorsqu’on attaque le problème de bien préciser le système étudié, et l’origine du repère d’espace et de temps surtout si le sujet ne le précise pas.

Par exemple : dans le cas d’une chute libre verticale, on peut choisir de prendre comme origine du repère la position du système au moment où il est lâché et comme origine du temps le moment où il est lâché.

Un point délicat cependant : la direction dans laquelle on oriente le repère. Si l’on oriente l’axe vertical vers le bas, la gravité g sera égale à +g.k (où k est le vecteur unitaire de l’axe vertical). Si l’axe est orienté vers le haut, g=-g.k (voir le schéma ci-contre).

Faire l’inventaire des forces extérieures appliquées à ce système.

Bon, une compétence acquise depuis la seconde normalement. Généralement, on trouvera :

- le poids (du moment que l’expérience a lieu à la surface de la terre) : P=m.g

- la poussée d’archimède (dans l’eau mais aussi dans l’air, n’oubliez pas que les montgolfières et les ballons gonflés à l’hélium flottent) : Pa=-?.V.g

- les frottements (sauf si le sujet vous invite à les négliger) de l’air, de l’eau, etc.: leur expression est précisée dans le sujet

- la réaction du support (pour un objet posé sur le sol, une table, etc.) : perpendiculaire au support s’il n’y a pas de frottement, ayant une composante tangeante au support dans le cas contraire.

Bien sûr, cette liste n’est pas exhaustive et on peut trouver d’autres forces : l’interaction gravitationnelle exercée par une planète ou une étoile, l’interaction électrique, etc.

Définir le vecteur accélération et exploiter cette définition, connaître son unité.

Le vecteur accélération est défini comme le taux de variation du vecteur vitesse : a=?v/?t

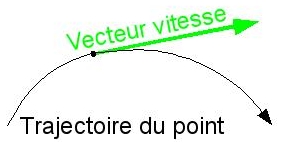

Pour bien définir le vecteur accélération, il faut avoir une idée claire sur ce qu’on appelle la vitesse. Dans la vie de tous les jours, la vitesse est un scalaire (un chiffre), alors qu’en physique c’est un vecteur, défini par sa norme, sa direction et son sens. Sa norme correspond à la définition de la vie de tous les jours : la distance parcourue par unité de temps (la seconde en physique), sa direction est tangeante à la trajectoire et son sens est celui du mouvement.

Pour bien définir le vecteur accélération, il faut avoir une idée claire sur ce qu’on appelle la vitesse. Dans la vie de tous les jours, la vitesse est un scalaire (un chiffre), alors qu’en physique c’est un vecteur, défini par sa norme, sa direction et son sens. Sa norme correspond à la définition de la vie de tous les jours : la distance parcourue par unité de temps (la seconde en physique), sa direction est tangeante à la trajectoire et son sens est celui du mouvement.

Selon la façon dont on appréhende le problème, les vecteurs vitesse et accélération vont s’écrire de différentes façons :

- Dans le cas d’une étude expérimentale où l’on a une collection de points M1, M2, M3, etc. correspondant à différentes positions du point étudié, vi=(OMi+1–OMi-1)/?t et ai=(vi+1–vi-1)/?t

- Dans le cas où l’on a OM(t) [x(t), y(t), z(t)], alors le vecteur vitesse se calcule en dérivant chacune des coordonnées : v(t) [dx/dt(t), dy/dt(t), dz/dt(t)]. Pour le vecteur accélération, c’est la même chose mais en dérivant les coordonnées de v(t) soit a(t) [dvx/dt(t), dvy/dt(t), dvz/dt(t)]=[d²x/dt²(t), d²y/dt²(t), d²z/dt²(t)]

L’unité de l’accélaration est celle de la vitesse divisée par du temps soit du m.s-2.

Enoncer les trois lois de Newton.

Première loi : également appelée principe d’inertie

Dans un référentiel galiléen, si le vecteur vitesse vG du centre d’inertie G du solide ne varie pas, la somme des forces extérieures qui s’exercent sur le solide est nulle et réciproquement :

Cette loi est généralement appliquée aux solides au repos ou en mouvement de translation rectiligne uniforme pour déterminer les forces qui s’y appliquent (par exemple pour un palet qui glisse sans frottement, la réaction de la glace est exactement opposée au poids du palet).

Seconde loi : également appelé postulat fondamental de la dynamique

Dans un référentiel galiléen, la somme des forces extérieures appliquées à un solide est égale au produit de sa masse par l’accélération de son centre d’inertie :

Dans cette dernière expression, les forces s’expriment en Newton (N), la masse en kilogramme (kg) et l’accélération en mètre par seconde carré (m.s-2). Nous allons beaucoup l’utiliser par la suitepour déterminer les trajectoires d’objets en mouvement.

Troisième loi : également appelé le principe des actions réciproques

Si 2 corps sont en interaction, alors la force exercée par le premier sur le second est égale et opposée à la force exercée par le second sur le premier :

Cette loi s’oublie facilement et pourtant elle est fondamentale pour comprendre le recul d’une arme à feu (voir par exemple la première question du bac 2007).

Savoir exploiter un document expérimental (série de photos, film, acquisition de données avec un ordinateur…) : reconnaître si le mouvement du centre d’inertie est rectiligne uniforme ou non, determiner des vecteurs vitesse et accélération, mettre en relation accélération et somme des forces, tracer et exploiter des courbes vG = f(t).

Pour une série de points M1, M2, M3, etc. nous avons vu comment déterminer les vecteurs vitesses et accélération. Bien entendu, si le mouvement est un mouvement rectiligne uniforme, la trajectoire sera une droite et deux points consécutifs seront toujours à la même distance les uns des autres.

Pour vous entraîner : les questions de 1.1 à 1.5 de Pondichéry 2005 sont une application directe des points qui viennent d’être discutés.

Actuellement, nos voitures fonctionnent en effectuant une réaction d’oxydation des hydrocarbures présents dans l’essence :

Actuellement, nos voitures fonctionnent en effectuant une réaction d’oxydation des hydrocarbures présents dans l’essence : La première idée qui vient à l’esprit c’est de remplacer l’essence par un carburant tout aussi énergétique mais renouvelable. Ainsi, certains constructeurs ont mis au point des voitures qui roulent au bioéthanol. Ce carburant est d’origine agricole. C’est à dire qu’on le produit à partir de colza ou d’autres huiles végétales.

La première idée qui vient à l’esprit c’est de remplacer l’essence par un carburant tout aussi énergétique mais renouvelable. Ainsi, certains constructeurs ont mis au point des voitures qui roulent au bioéthanol. Ce carburant est d’origine agricole. C’est à dire qu’on le produit à partir de colza ou d’autres huiles végétales. L’idée qui vient immédiatement à l’esprit est l’utilisation de panneaux solaires. En effet, l’énergie solaire est gratuite, directement accessible et éternellement renouvelable (tout du moins pour les 4 milliards d’années à venir). Encore une fois, il y a un hic : la terre reçoit du soleil environ 1000 Watt par m2 (1 kW/m2). Ainsi, il faut présenter une grande surface de panneau solaire pour faire avancer une voiture (voir l’image ci-contre). Une petite voiture développe environ 100 chevaux ce qui correspond à 100 kW. Il faudrait donc 100 m2 de panneaux solaires pour avoir la même puissance : il va falloir revoir la taille de nos routes !

L’idée qui vient immédiatement à l’esprit est l’utilisation de panneaux solaires. En effet, l’énergie solaire est gratuite, directement accessible et éternellement renouvelable (tout du moins pour les 4 milliards d’années à venir). Encore une fois, il y a un hic : la terre reçoit du soleil environ 1000 Watt par m2 (1 kW/m2). Ainsi, il faut présenter une grande surface de panneau solaire pour faire avancer une voiture (voir l’image ci-contre). Une petite voiture développe environ 100 chevaux ce qui correspond à 100 kW. Il faudrait donc 100 m2 de panneaux solaires pour avoir la même puissance : il va falloir revoir la taille de nos routes ! Le dihydrogène (H2) réagit très violemment avec le dioxygène de l’air pour former de l’eau :

Le dihydrogène (H2) réagit très violemment avec le dioxygène de l’air pour former de l’eau :

Voilà une question qu’on entend beaucoup au début de l’année de terminale S, lorsqu’on fait le cours sur les équilibres chimiques.

Voilà une question qu’on entend beaucoup au début de l’année de terminale S, lorsqu’on fait le cours sur les équilibres chimiques.